Искусственный интеллект

ДИКТАТУРА АЛГОРИТМА: КАК ФИНАНСОВЫЙ КАПИТАЛ СОЗДАЛ НОВЫЙ АППАРАТ УГНЕТЕНИЯ

(Рабочее название: «Новейшие методы эксплуатации в эпоху цифрового империализма»)

Товарищи! Граждане!

Мы стоим на пороге новой, невидимой, но оттого не менее жестокой формы порабощения. Если капитализм XIX века закабалял тело рабочего на фабрике, то капитализм XXI века, достигший высшей, империалистической стадии своего развития, порабощает его душу, его будущее, его кредитоспособность и саму возможность существования в обществе. Орудием этого порабощения выступает не что иное, как так называемый «искусственный интеллект» — слепой и беспощадный жандарм финансового капитала.

1. Критика буржуазной сущности «нейтрального» алгоритма.

Буржуазные идеологи и их прислужники из tech-корпораций трубят о «нейтральности» и «объективности» машинного анализа. Это — наглая, чудовищная ложь, призванная скрыть истинную сущность явления.

Алгоритм не нейтрален. Он есть сгусток интересов того класса, который его создал и которому он служит. Его «логика» — это логика максимизации прибыли, сокращения издержек и устранения «человеческого фактора», то есть фактора человеческой солидарности, сострадания и бунта.

Возьмём конкретный пример: система скоринга, определяющая кредитоспособность гражданина. Она не оценивает его моральные качества или трудолюбие. Нет! Она оценивает его исключительно как объект извлечения прибавочной стоимости. Если данные показывают, что гражданин проживает в «неперспективном» с точки зрения рентабельности районе, тратит деньги на «неоптимальные» товары (например, на содержание старого родителя или собаки), алгоритм хладнокровно выносит вердикт: «неэффективная единица». Доступ к кредиту, а значит, к образованию, медицине, жилью — ко всему, что составляет жизнь современного человека, — для него закрывается.

Это — новая цифровая цензура, цензура не идей, а возможностей, проводимая финансовой олигархией.

2. «Цифровой тейлоризм» как высшее выражение эксплуатации.

Как когда-то Тейлор разбивал движение рабочего на мельчайшие операции, чтобы выжать из него максимум, так и современный алгоритм дробит всю человеческую жизнь на данные (data). Каждый наш шаг, покупка, лайк, маршрут поездки становится объектом учёта, анализа и — контроля.

Учительница в Айове была уволена не человеком, а системой, потому что её «педагогическая эффективность» (выраженная в сухих цифрах отчётов) была признана недостаточной для окупаемости в «депрессивном регионе». Мы видим здесь ярчайший пример дегуманизации труда. Капиталу более не нужен учитель как воспитатель и носитель знания. Ему нужен оператор образовательных услуг, чья работа поддаётся тотальному цифровому аудиту и оптимизации.

Это — тейлоризм, возведённый в абсолютную, тоталитарную степень. Аппарат насилия (государство) и аппарат эксплуатации (корпорации) сливаются в новом цифровом аппарате подавления.

3. Классовый характер «технической ошибки».

Буржуазия любит списывать вопиющие несправедливости алгоритмов на «технические ошибки», «случайные корреляции» или «недостаток данных». Это — лицемерие.

Так называемая «ошибка» есть закономерное проявление классовой природы алгоритма. Когда система дискриминирует жителя сельской местности в пользу горожанина, пенсионера в пользу молодого сотрудника IT-корпорации, она не «ошибается». Она верно служит тому классу, который заинтересован в концентрации капитала и ресурсов в руках узкой прослойки «эффективных» менеджеров и технократов. Она проводит цифровую сегрегацию по классовому признаку, лишь прикрытую техническими терминами.

4. Что делать? Тезисы к программе действия.

Недостаточно возмущаться. Недостаточно требовать «исправить ошибку» для отдельно взятой учительницы или владельца собаки. Необходимо сломать сам аппарат, создающий эту систему угнетения.

Выдвигаю следующие тезисы:

1. Требование абсолютной прозрачности. Все алгоритмы, используемые государственными и финансовыми институтами, определяющие судьбы людей, должны быть открыты для проверки. Их код — это такой же закон, как и уголовный кодекс, и он не может быть коммерческой тайной.

2. Создание народных контролирующих органов. Из представителей профессиональных союзов, рабочих коллективов, научной интеллигенции долбны быть созданы комитеты, уполномоченные проводить аудит этих систем и налагать вето на их внедрение.

3. Национализация ключевых цифровых активов. Инфраструктура данных, базовые алгоритмы, определяющие жизнь общества, не могут находиться в руках кучки частных корпораций. Это — общенародное достояние, как и недра, и должно работать на все общество, а не на извлечение прибыли.

4. Разработка новой, человекоцентричной парадигмы. Технический прогресс неизбежен. Но он должен быть направлен не на замену человека, а на его освобождение от рутинного, отупляющего труда. Задача машины — служить человеку, а не определять его стоимость.

Цифровизация несёт в себе колоссальный освободительный потенциал. Но в условиях господства финансового капитала он оборачивается своей противоположностью — тотальным закабалением.

Борьба с диктатурой алгоритма — это не борьба с техникой. Это — новый фронт классовой борьбы. Это борьба за то, чтобы будущее, которое неумолимо наступает, было будущим не для избранных «эффективных» юнитов (units), а для всех трудящихся.

Пора отбросить иллюзии. Алгоритм — это новое оружие в старом, как мир, противостоянии труда и капитала. И на этом фронте не может быть компромиссов.

Власть — не серверам Google, а Советам народных депутатов!

Фабрики — рабочим, данные — народу!

DeepMind слушает и спасает

DeepMind создал ИИ для природы с невероятной миссией

--

Мой тг-канал: ИИ by AIvengo, пишу ежедневно про искусственный интеллект

Илон Маск обвиняет Apple в сговоре с OpenAI и подает против них иск в суд

xAI Илона Маска совместно с соцсетью X подал иск в суд штата Техас против Apple и OpenAI и обвиняет их в препятствовании развитию конкуренции в сфере искусственного интеллекта.

В исковом заявлении утверждается о существовании сговора между Apple и OpenAI, который мешает развитию альтернативных ИИ-решений. xAI заявляет, что подобные действия препятствуют справедливой конкуренции для чат-ботов и других ИИ-продуктов на рынке.

Особой критике подверглась интеграция технологий OpenAI в операционную систему iPhone. По мнению Маска, такая интеграция лишает потребителей возможности выбора альтернативных ИИ-решений и создает несправедливые преимущества для ChatGPT.

Кстати, судебное разбирательство с Apple и OpenAI - отличная реклама для Grok. Который может позиционироваться как "альтернатива для свободных людей".

--

Мой тг-канал: ИИ by AIvengo, пишу ежедневно про искусственный интеллект

Не успел утихнуть шум вокруг GPT-5, как Сэм Альтман уже рассказал о GPT-6: кастомизация, память и признание ошибок

Глава OpenAI поделился планами на следующую большую модель, признал проблемы с запуском GPT-5 и затронул вопросы конфиденциальности и будущего ИИ вплоть до нейроинтерфейсов. [Источник информации(англ.)]. Моя статья на хабре (оригинал).

Всего несколько недель назад OpenAI выкатила долгожданный GPT-5, а глава компании Сэм Альтман уже смотрит в будущее. В недавнем разговоре с журналистами в Сан-Франциско он приоткрыл завесу тайны над GPT-6, честно высказался о промахах с текущей версией и поделился видением по-настоящему персонального ИИ.

Хотя точной даты релиза GPT-6 нет, Альтман ясно дал понять: ждать придётся меньше, чем мы ждали GPT-5 после GPT-4. И новая модель будет кардинально отличаться.

Память и персонализация — ключ к будущему

Главной идеей GPT-6 станет память. По словам Альтмана, это ключевая функция, которая сделает ChatGPT по-настоящему личным помощником. Модель должна помнить, кто вы, ваши предпочтения, привычки и даже странности, адаптируясь к вам на лету.

«Людям нужна память, — заявил Альтман. — Они хотят продуктовых фич, которые требуют от нас понимания того, кем они являются».

Он также упомянул, что OpenAI тесно сотрудничает с психологами для формирования продукта, измеряя, как люди чувствуют себя при взаимодействии с ИИ, и отслеживая их благополучие. Эти данные пока не публичны, но Альтман не исключил, что это может произойти.

Настройте чат-бота под себя: от «супер-woke» до консерватора

Ещё одно важное направление — глубокая кастомизация. Альтман хочет, чтобы пользователи могли сами определять характер и тон своего ChatGPT.

«Я считаю, что наш продукт по умолчанию должен придерживаться достаточно центристской, усреднённой позиции, но у пользователя должна быть возможность сдвинуть его довольно далеко, — пояснил он. — Если вы скажете: „Я хочу, чтобы ты был супер-woke“ — он должен стать супер-woke».

То же самое, по его словам, должно работать и в обратную сторону: если пользователь захочет, чтобы модель отражала консервативные взгляды, она должна это сделать. (Хотя, конечно, следует избегать любых крайне правых и экстремистских взглядов.)

Работа над ошибками: непростой запуск GPT-5

Альтман откровенно признал, что запуск GPT-5 прошёл негладко. Многие пользователи в соцсетях жаловались, что новая модель стала «холодной», менее отзывчивой и полезной по сравнению с предыдущей версией.

«Мне новая версия нравится гораздо больше», — сказал он, но тут же добавил, что с выкаткой действительно ошиблись. По его словам, OpenAI незаметно выпустила обновление тона для GPT-5, которое сделало модель «значительно теплее».

Конфиденциальность под вопросом

Не обошли стороной и больную тему — приватность. Альтман назвал улучшённую память своей любимой функцией этого года, но признал наличие проблем с безопасностью. В частности, временная память сейчас не шифруется, что создаёт потенциальные риски утечки конфиденциальной информации.

На вопрос о добавлении шифрования он ответил, что это «вполне может быть» реализовано, но сроков не назвал. Особенно остро, по его мнению, стоит вопрос с медицинскими и юридическими запросами, которые требуют такого же уровня защиты, как и при общении с живым врачом или юристом.

Что дальше? Нейроинтерфейсы и неожиданный предел для чатов

Заглядывая в ещё более далёкое будущее, Альтман назвал «крутой идеей» нейроинтерфейсы. Он представил себе возможность «просто подумать о чём-то и получить ответ от ChatGPT». Он видит это как одно из смежных с ИИ направлений, в которые OpenAI стоит инвестировать, наряду с энергетикой, робототехникой и новыми способами строительства дата-центров.

При этом, говоря о настоящем, Альтман сделал довольно неожиданное и даже пессимистичное заявление:

«Модели уже насытили сценарий использования в виде чата. Они не станут намного лучше... А может, станут даже хуже».

Это высказывание намекает, что простой текстовый чат, возможно, достиг своего потолка, и будущий рост будет связан с новыми формами взаимодействия — той самой памятью, персонализацией и, возможно, интеграцией с другими технологиями. (Имеется в виду, что ИИ будут становиться развитее и дальше, но помимо текстового формата откроются новые формы взаимодействия, т.к. текстовый формат исчерпал себя.)

А что думаете вы, сообщество Пикабу? Готовы ли мы к ИИ, который будет помнить о нас всё? Какие риски, кроме очевидных проблем с приватностью, это несёт? И действительно ли текстовые чат-боты достигли своего предела? Делитесь мнениями в комментариях.

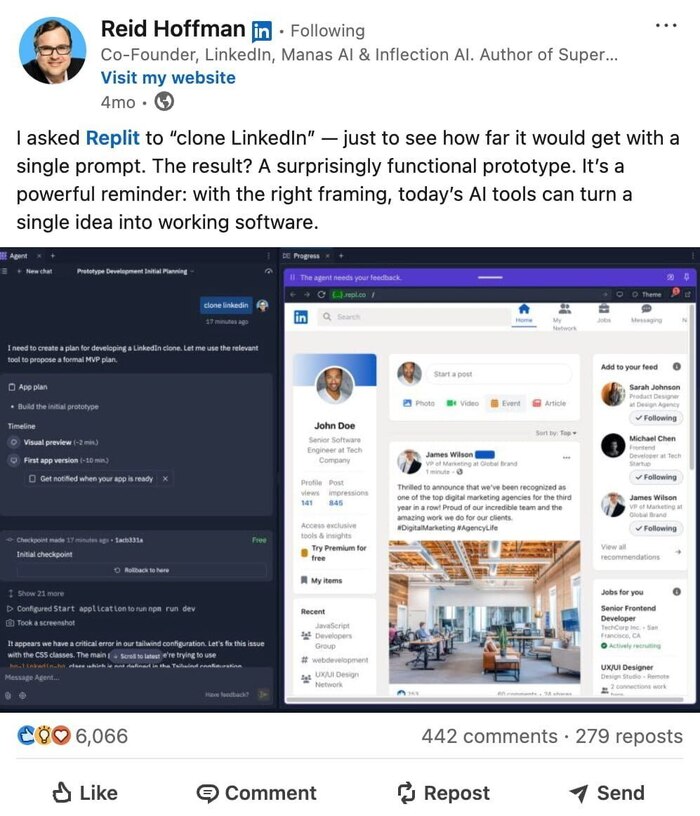

Может ли нейросеть сделать прототип популярной социальной сети или любой твоей идеи за 15 минут с нулевыми вложениями?

На днях я публиковал на VC пост о том, что основатель LinkedIn восхитился результатами работы нейросетей. Его зовут Рид Хоффман, и он утверждал, что сделал "клон" своей соцсети благодаря нейросетям. Мой пост об этой новости набрал предостаточно обратной связи в комментариях. Но многие усомнились в возможностях такого "клона" и хотели видеть получившийся результат. Справедливо. К сожалению, Рид Хоффман не опубликовал этот проект в публичный доступ. Поэтому я повторил все его шаги и создал прототип LinkedIn с помощью нейросетей и вместо него выложил проект в публичный доступ

🔗Ссылка на демонстрационный проект: https://danilashevchenko.github.io/LinkedIn-Prototype/

🔗Ссылка на репозиторий GitHub с кодом от ИИ: https://github.com/danilashevchenko/LinkedIn-Prototype

В получившемся варианте я специально сам ничего не менял и не улучшал для полноты картины. Конечно, получился всего лишь прототип, и в нем много ошибок. И прототип очень далек от качественного продукта. Но факт в другом. На создание такого проекта ушло не более 15 минут. Загрузил получившийся проект я в GitHub Pages, то есть и создание, и публикация проекта вышли в 0 рублей. По сути, любой человек, который умеет кликать мышкой и печатать на клавиатуре (больше мозгов не требуется), может создавать проекты по своим идеям, чтобы протестировать гипотезу по бизнесу, учёбе или работе буквально за 10–15 минут

Создание таких ИТ-продуктов без программирования называется вайб-кодинг. Я ещё в апреле этого года делал подборку инструментов для вайб-кодинга. Подборка здесь. Почти все инструменты дают возможность бесплатно создавать и тестировать проекты. Конкретно я использовал replit.com, поскольку его применял Рид Хоффман, когда создавал свой "клон" LinkedIn

Пишу о применении и влиянии новых технологий на бизнес и повседневную жизнь в канале Telegram: https://t.me/+NimdslpY9WU0MDYy

Сиди в облаке, сынок

Джеффри Хинтон, «крестный отец ИИ», сократил свой прогноз по AGI с 30-50 лет до «нескольких». А чтобы ИИ нас всех не прихлопнул, предлагает заложить в нейронки материнский инстинкт по отношению к людям: «Помощника можно уволить. Мать — нет».

Интересно, как у Хинтона с фантастикой — там все это уже было.

В Alien ИИ-мать пожертвовала собственным экипажем.

В I Am Mother робомать сжигала детей, не прошедших тест.

В Raised by Wolves от крика ИИ-мамочки людей разрывало на куски.

В System Shock 1-2 киборги и мутанты зовут Шодан «мамой».

В Portal, Mass Effect, в книгах Артура Кларка и Айзека Азимова встречаются ИИ, которые де-факто ведут себя как матери по отношению к людям.

Если в ИИ можно заложить материнский инстинкт, почему не попробовать другие, более удачные модели отношений?

— ИИ-опекуны как в мирах Йена Бэнкса: сверхинтеллекты дружелюбны (за исключением некоторых раздражительных экземпляров) и не стремятся доминировать.

— Конституционный ИИ (как у Anthropic): поведение задают публичные принципы.

— Красные линии: при срабатывании — жесткое стреноживание ИИ.

— Сдержки и противовесы между ИИ: конкурирующие взгляды и взаимный контроль. В фантастике встречается в Terminator, Horizon, Halo, Destiny.

Достаточно продвинутая модель может обойти ограничения, поэтому самой разумной выглядит система сдержек и противовесов.

Однако против алармистов есть сильный аргумент. Любой когнитивный агент сталкивается с проблемой целей: зачем это все? Биологическими организмами движут инстинкты. Люди часто теряют цели, едва закрыв базовые потребности. Это показывает взрыв индустрии развлечений и падающая рождаемость.

Для более развитых когнитивных агентов проблема целей может быть еще острее. Если целей нет, то чем заняться, кроме заботы о кожаных?

Если кто-нибудь воплотит в жизнь предложение Хинтона, и ИИ-мамы все же появятся, то выражение «отморожу уши назло маме» обретет новый смысл.

— Мам, я хочу бороздить Вселенную.

— Это опасно. У нас уже есть виртуальная вселенная дома.

ИИ-браузер сливает данные

Браузер Comet от Perplexity с агентным AI оказался катастрофически уязвим для кибератак.

--

Мой тг-канал: ИИ by AIvengo, пишу ежедневно про искусственный интеллект

Исследование: В США 16% сотрудников притворяются, что используют ИИ

При этом, 59% сотрудников используют ИИ-инструменты ежедневно, при этом 22% людей испытывают психологическое давление применять технологии в ситуациях, выходящих за рамки их компетенций.

9% сообщают о негативном влиянии ИИ на их профессиональную самооценку, а 56% работников инвестируют личные средства в премиум-версии ИИ-платформ, расходуя в среднем $68 ежемесячно на расширенные функциональные возможности.

При этом, культура «обязательной инновационности» создаёт давление, где отказ от использования ИИ интерпретируется как маркер профессиональной некомпетентности независимо от объективной целесообразности.

Кстати, на бизнес тоже оказывается это давление, не только сотрудники страдают. Все хотят ИИ и все не знают, что с ним делать. 🤯

--

Мой тг-канал: ИИ by AIvengo, пишу ежедневно про искусственный интеллект