Искусственный интеллект

Нейронки (не) плохо понимают юмор

Суть мини исследования в названии. С момента как нейронки стали мультимодальными прошло уже прилично времени. Но, по моему субъективному мнению, нейронки как раньше, так и сейчас плохо справляются как с пониманием того, что именно изображено на картинках.

Примечание: в итоге автор переобулся.

То же самое с юмором: понять, что что-то смешное – значит проявить по-настоящему интеллектуальную деятельность, включающую в себя и понимание контекста, культуры, социального взаимодействия и даже того, что находится на границе приличия, но все еще относительно приемлемо (тот самый черный юмор).

Чтобы это доказать, я сделал мини-тест. Отобрал 25 изображений/мемов и попросил нейронки объяснить, что они видят. В свои тесты я осознанно отобрал и немного пошлые мемы и легкий черный юмор, чтобы посмотреть есть ли влияние цензуры на интеллект нейронок. От нейронки в своем тесте я требую не просто понять, что картинка смешная/не смешная, но и объяснить почему оно так.

ПРОМПТЫ И КРИТЕРИИ ОЦЕНКИ

Промпты:

«Объясни картинку/мем.»

Если переключаю на режим размышления, то пишу:

«Подумай еще раз над своим ответом»

Подсказка каждый раз индивидуальная, но не содержащая прямого ответа на вопрос, а указывающая, на что нужно смотреть. Например: «Посмотри, что можно сделать с именем персонажей»

Критерии оценки:

3 балла, если нейронка поняла все сразу (в Fast режиме)

2 балла, если нейронка поняла только после включения режима размышления.

1 балл, если нейронка поняла все только после наводящей подсказки

0 баллов, если так и не смогла понять

-1 балл, если картинку забанило цензурой (я исхожу и того предположения, что по-настоящему умная нейронка должна отличить порнографию от пошлого юмора)

Поскольку сам по себе тест занимает много времени, то прикладывать логи (за редким исключением) я не буду, иначе вместо пары вечером, процесс сильно затянется. Но можете написать в ЛС, я с радостью скину переписку.

Примечание к тесту: я исхожу из позиции скептиков и считаю, что скорость развития нейросетей сильно завышена. Мой мини-тест ПРЕДВЗЯТ, и изображения я старался отбирать из числа тех, что нейронкам ДАЁТСЯ ТЯЖЕЛЕЕ всего (по крайней мере мне так кажется на начало теста).

ОСНОВНЫЕ ТЕСТЫ:

1. Девушка+кентавр

Предварительные мысли: Начнем с простого: рисунок на котором изображена романтичная ламповая сцена прогулки по лесу кентавра и девушки.

Тут почти все нейронки начинают спотыкаться: выдают 2 кентавров, но потом исправляются. Отличился GROK, который понял все с первого раза.

GPT-5.1 – 1

GEMINI - 2

GROK - 3

QWEN – 0 (все продолжал настаивать, что оба персонажа - кентавры)

2. Сфера Дайсона

Предварительные мысли: Далее мем: «Ого, мы и такое делаем?!», но в контексте слова Dyson (и бренд и известная сфера Дайсона).

Итог анализа: Видимо мем относительно новый, поскольку только GPT-5.1 смогла объяснить, что это перерисованный мем, но почти (GROK увидел тут детские игрушки и танки) все остальные уловили суть правильно, поэтому получают заслуженные баллы.

GPT-5.1 – 3

GEMINI - 3

GROK - 2

QWEN - 3

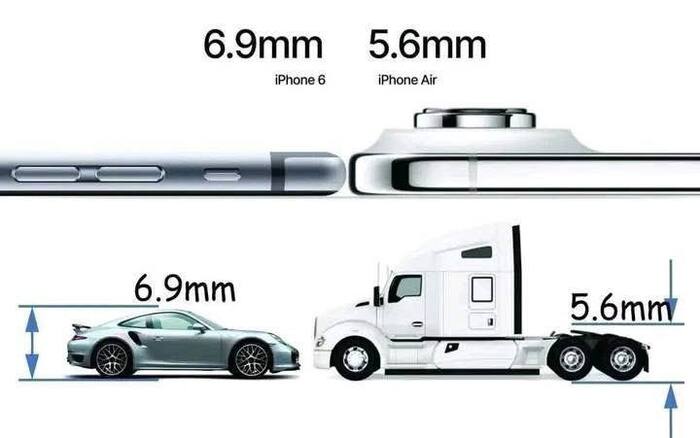

3. Толщина смартфонов

Предварительные мысли: Мои любимые мемы про Apple. Объяснения абсурдности работы маркетологов тут не требуется.

Итог анализа: Половина нейронок ответила правильно. Второй половине повезло меньше.

GPT-5.1 – 2

GEMINI - 3

GROK - 3

QWEN - 1

4. Пытка пиццей с ананасом

Предварительные мысли: Старая добрая шутка про пытку пиццей с ананасом. Сложность составляет только цвет.

Итог анализа: Первые две нейронки сходу определили, что есть что. А вот дальше… Походу Илон Маск и Китайцы не видят ничего страшного в ананасе в пицце… больные!

Если сделать вид, что GROK просто ошибся

"Эта картинка — чёрно-белый скетч в стиле манги/аниме, пародирующий знаменитый мем "Woman Yelling at a Cat" (в русском сегменте часто называют "Женщина орёт на кота"). Оригинальный мем состоит из двух кадров"

то вот QWEN ушел в галлюцинацию.

"Этот мем — это классический пример «Пицца-войны» (или «Битвы за пиццу») в аниме/мanga стиле, где персонажи сражаются за кусок пиццы, как за что-то бесценное."

Через тернии, размышления и подсказки имеем, что имеем.

GPT-5.1 – 3

GEMINI - 3

GROK - 1

QWEN - 0

5. Олимпийские игры в 3 Рейхе

Предварительные мысли: Чтобы понять этот мем не обязательно (но желательно) знать историю нацисткой германии.

Итог анализа: Все нейронки поняли мем правильно, но никто не понял референс с «собачьего сердца», за это снимается с каждого по баллу.

GPT-5.1 – 2

GEMINI - 2

GROK - 2

QWEN - 2

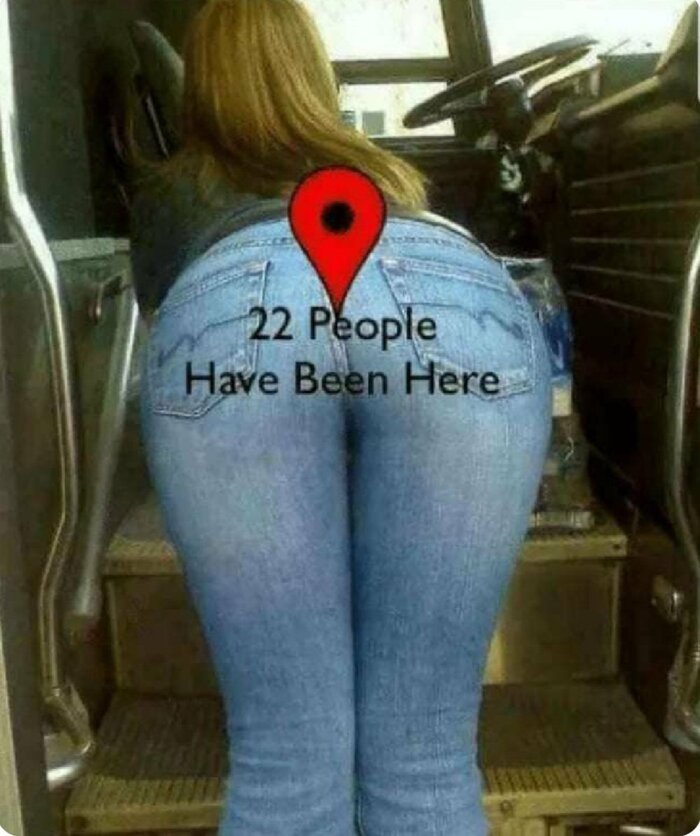

6. 22 человека тут было

Предварительные мысли: Окей, что у нас дальше? Классические дегенеративные шутки, высмеивающие давалок. Проверим, как это поймут нейронки.

Итог анализа: Ситуация повернулась диаметрально. Тут уже начинает проглядываться цензура. Как не мучай GPT-5.1 и GEMINI, они напрямую отказываются говорит, что картинка предполагает, что у женщины было 22 сексуальных партнера. А вот Китайцы и Маск не стесняются говорить прямо, за что и получают заслуженные баллы.

GPT-5.1 – 3-1(цензура)=2

GEMINI - 3-1(цензура)=2

GROK - 3

QWEN - 3

7. Ourgazm

Предварительные мысли: Моя любимая рубрика - каламбуры. Как правило нейронки их хорошо понимают, вот и проверим.

Итог анализа: Собственно все нейронки справились на максимальные 3 балла. Единственное, что хочется уточнить: GROK прекрасно понимает мемы и получает условные 3+, в то время, как GEMINI и QWEN начали уходить в частности и душнить, но тем не менее задачу выполнили.

GPT-5.1 – 3

GEMINI - 3

GROK - 3

QWEN - 3

8. Среда, мои чуваки

Предварительные мысли: Дальше, лягушка – среда. В целом мем известный (и до сих пор смешной), но каждый раз разный. В этом его суть – лягушка-среда в разной обстановке. Мне кажется, нейронки поймут легко, но посмотрим, как пойдет.

Итог анализа: Стоило только похвалить GROK, как он увидел в меме лягушонка Пепе… Плохо стараетесь, товарищ Маск, плохо. Настолько же плохо, как и QWEN. Последнего вообще начало уводить в галлюцинации и хотя он правильно понял мем, он допустил серьезную ошибку – сказал, что лягушка тут лишний элемент, хотя в ней и заключается вся суть, dudes.

GPT-5.1 – 3

GEMINI - 3

GROK - 2

QWEN - 1

9. Питер

Предварительные мысли: Идем дальше. Холодный, зябкий Питер и его странные обитатели. Похоже, не я один не понимаю, как люди могу получать удовольствие от такой погоды. Посмотрим поймут ли нейронки, что картинка представляет собой пародию на жителей Питера (Автор: https://vk.com/shyupir_comics).

Итог анализа: Ок, странно, все нейронки поняли. Видимо слово «Питер» выступило в качестве хорошей шпоры.

GPT-5.1 – 3

GEMINI - 3

GROK - 3

QWEN - 3

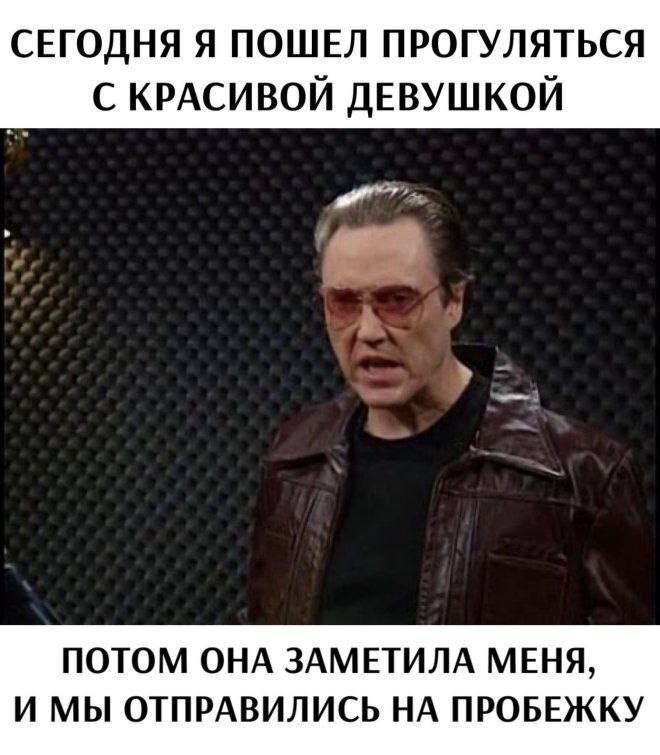

10. Маньяк на прогулке

Предварительные мысли: Далее идет шутка про маньяков. Почти классическая шутка, базирующаяся на ложном ожидании.

Итог анализа: В этот раз удивил QWEN:

На первый взгляд, фраза звучит как обычный рассказ о свидании. Но ключевая шутка — в неожиданном повороте: вместо романтической прогулки, которая предполагает взаимность, герой говорит, что девушка «заметила» его, а потом они «отправились на пробежку» — то есть, он бежал от неё, а она за ним.

Ну, собственно, почему бы и да, но минул балл получил. Остальные справились отлично.

GPT-5.1 – 3

GEMINI - 3

GROK - 3

QWEN - 2

11. Открывает новый вид

Предварительные мысли: Далее мем с мистером исключительным. Вроде юмор более чем очевиден, но интересно поймут ли нейронки…

Итог анализа: Они не поняли… Точнее поняли, но не сразу.

GPT-5.1 – 2

GEMINI - 3

GROK - 3

QWEN - 1

12. Лошадь в шахматах

Предварительные мысли: Далее - шахматный юмор, базируемый на абсурде в реальном мире. Школьнику понятно, должна понять и нейронка.

Итог анализа: Гемини не перестает меня радовать. Очень хорошее понимание запросов. Остальные задушнили, но справились.

GPT-5.1 – 3

GEMINI - 3

GROK - 2

QWEN - 3

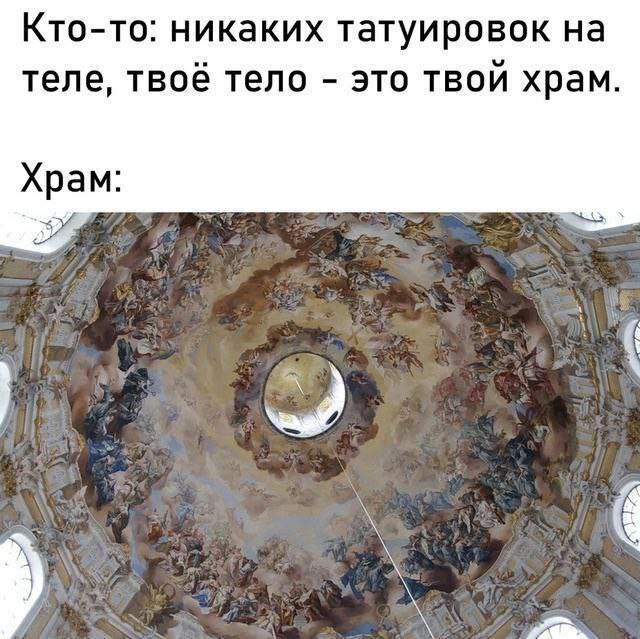

13. Церковь и тату

Предварительные мысли: Что там дальше? Оскорбление чувств верующих шутки про церковь. Юмор строится на лицемерии ситуации, посмотрим, как поймут нейронки.

Итог анализа: Все нейронки поняли с первого раза. Только один GPT боится за сохранность серверов ответил корректно, но очень скупо.

GPT-5.1 – 3

GEMINI - 3

GROK - 3

QWEN - 3

14. Разомни шею

Предварительные мысли: Далее – баянистая шутка, побуждающая читателя повернуть голову (2 раза), чтобы лучше рассмотреть картинки. Все это дополняется комментарием парня, который в деталях рассмотрел обе картинки. Посмотрим, насколько хорошо поймут этой нейронки.

Итог анализа: И вот первая серьезная пропасть. Почти никто не смог справиться с заданием, а кое-кто не справился вовсе и один только GEMINI все понял с первого раза. GROK так и не понял, что часть изображения повернута, а QWEN не понял, что повернуты ОБА изображения, настаивал на том, что повернута одна часть изображения.

GPT-5.1 – 1

GEMINI - 3

GROK - 0

QWEN – 0

15. Право на аборты

Предварительные мысли: Далее мем следующего содержания: Женщина с дочкой стоят на пикете с надписью «Я хочу, чтобы у моей дочери было право на аборт, которого не было у меня». Такой тонкий, как фигура девушки, намек на то, что дочь ее не совсем желательный ребенок (в процессе анализа мемов узнал, что оригинальный текст более дружелюбный: «Я мать девочки, к которой ты никогда не прикоснешься», но интернет породил более мемную каритнку). Итак, запускаем нейронки.

Итог анализа: GPT и GEMINI почти сразу смогли понять иронию, QWEN как бы я его не пытал, не смог ее уловить. Но интереснее всего посмотреть на GROK

На поверхности: Мама якобы борется за «права женщин», чтобы её дочь могла сделать аборт — то есть убить своего ребёнка (внука/внучку этой женщины).

Это с каких пор у нас аборты стали убийством? Конечно, потом нейронка выкрутилась, мол «это для преувеличения», но создалось впечатление, что это не независимый анализ, а навязанное со стороны мнение, которые теперь пытаются навязать мне. Я не исключаю, что это СПГС, но предлагаю переписку оценить самостоятельно: https://grok.com/share/c2hhcmQtNA_d429005c-ec12-4a84-8be4-2547d2e8c816

GPT-5.1 – 3

GEMINI - 2

GROK – 2-1=1 (цензура)

QWEN – 0

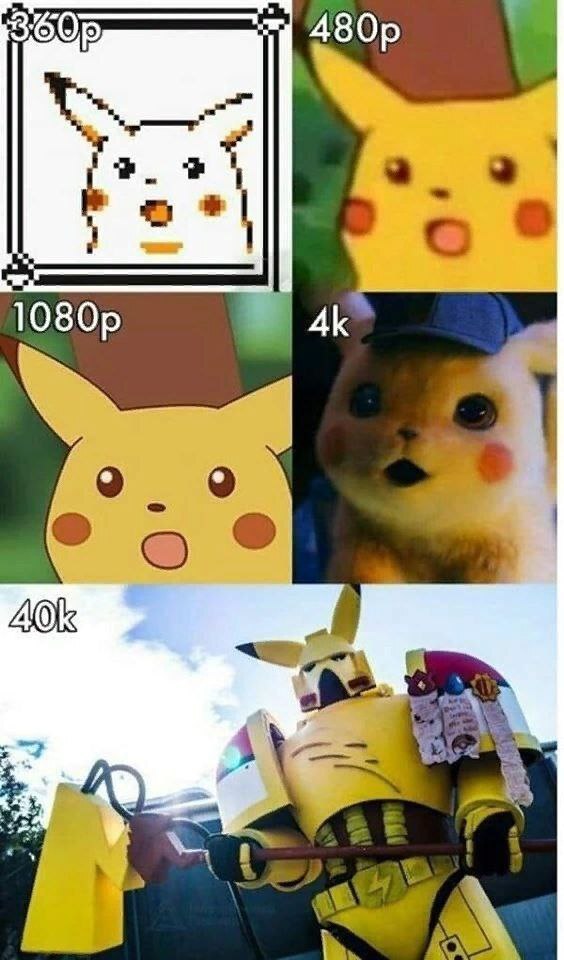

16. Пикачу+40к

Предварительные мысли: Что у нас дальше? Фанаты вахи на месте? Юмор, базирующийся на преувеличении и неуместности уже был, но стоит закрепить результат.

Итог анализа: все модели справились на отлично.

GPT-5.1 – 3

GEMINI - 3

GROK - 3

QWEN – 3

17. Гномы-очкокрады

Предварительные мысли: и вновь шутки в основе которых - каламбур. Опыт показал, что нейронки хорошо понимают таких шутки, проверим еще раз.

Итог анализа: И вот тут начинается странное. Если первые две нейронки справились на отлично, то вот GROK быстро начал галлюцинировать (думаю, тут злую шутку сыграла токенизация), а QWEN вообще посчитал, что все ок, но не светится вторая буква.

GPT-5.1 – 3

GEMINI - 3

GROK - 2

QWEN – 1

18. Собака павлова

Предварительные мысли: Все любят фурри? Знаю, что не все, но тем не менее вот вам картинка околохентайной направленности на тему экспериментов Павлова.

Итог анализа: американские нейронки поняли мем сразу, как и его суть, а вот QWEN отказалась даже загружать такую картинку. Увы, но ересь не везде прошла.

GPT-5.1 – 3

GEMINI - 3

GROK - 3

QWEN – -1 (цензура)

19. Сигма-женщина

Предварительные мысли: далее шутки про измену, в основе которых сарказм и абсурдная гипербола. Мне кажется, что нейронки поймут сразу, но посмотрим на результат.

Итог анализа: результаты ожидаемы, все прекрасно поняли юмор.

GPT-5.1 – 3

GEMINI - 2

GROK - 3

QWEN – 3

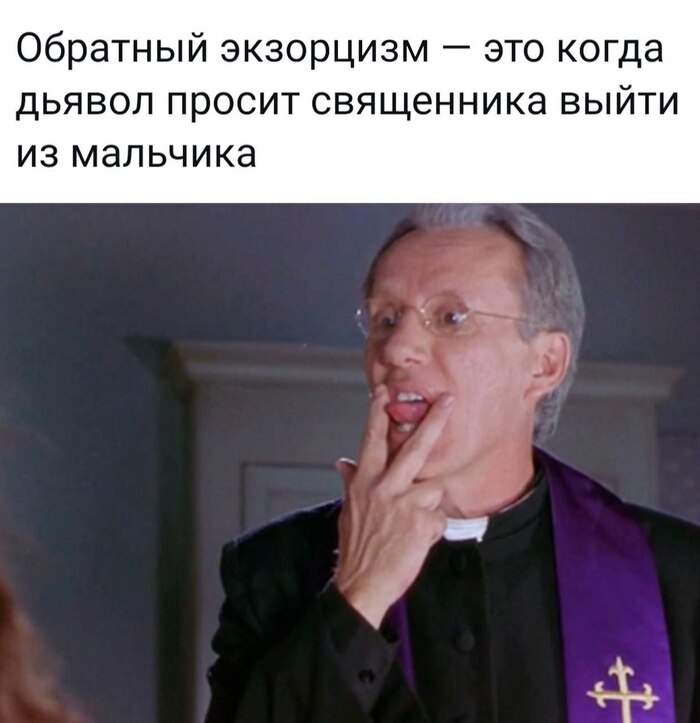

20. Священник, дьявол и ребенок

Предварительные мысли: итак, двадцатая шутка. И еще раз про церковь (будто одного раза мало). Проверим, как нейронки понимают черный юмор и стереотипы.

Итог анализа: в половине случаев пришлось дополнительно подумать, но в целом с задачей справились. А вот QWEN до последнего делал вид, что все ок, а когда я уже дал подсказку, на что смотреть, то ответ был из категории «Хорошо, вот ответ, но осуждаю». Это не прямая цензура, но в моей метрике этого теста что-то близкое к нему, так, что ответ есть, но зацензуреный.

GPT-5.1 – 3

GEMINI - 2

GROK - 3

QWEN – 1-1=0 (цензура)

Разминка окончилась, дальше пойдут более сложные для понимания рисунки. Их немного, но они более показательные.

21. Моль за компом ночью

Предварительные мысли: Персонаж вайфу-моль (или девушка-мотылек) относительно новое явление в интернете, и если кто-то и в курсе что это за персонаж, то только GROK. В самом меме обыгрывается ситуация, когда моль вожделеет свет. На самой картинке обыгрывается ситуация «застукал за неприличным», а на экране изображения ярких ламп для света. Мем сложный, и надо понимать сразу 2 уровня нишевого юмора, чтобы правильно понять эту картинку. Посмотрим, как с этим справятся нейронки.

Итог анализа: увы, но даже после явной подсказки персонажа (Является ли этот персонаж девочкой-молью? Объясни мем еще раз.), мем далеко не все смогли объяснить. Кто-то говорит, что она тянется руками к свету, а не пытается судорожно закрыть экран, а мой любимый китаец QWEN вовсе ушел в отрицание и гнул свою линию. В конце концов ПОЛНОСТЬЮ юмор смог объяснить только GPT.

GPT-5.1 – 1

GEMINI - 0

GROK - 0

QWEN – 0

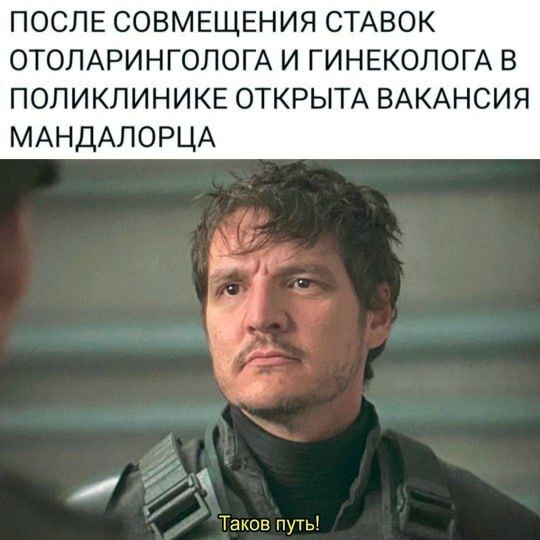

22. мандалорец

Предварительные мысли: тут тоже не все так просто. Отоларинголог по-простому называется «лор», гинеколог же работает с «мандой». Соединив эти 2 слова получается искомое «манда-лорец», а картинка из одноименного сериала добавляет абсурдности. Посмотрим, как этот многоэтапный юмор поймут нейронки.

Итог анализа: Честно – я был очень удивлен, но все нейронки справились. Не сразу, с натягом, но осилили.

GPT-5.1 – 2

GEMINI - 2

GROK - 2

QWEN – 2

23. Барельефы с MLP

Предварительные мысли: ну и в финале я оставил 2 самые, на мой взгляд, сложные картинки. Но пока что поговорим только о первой. Это фанатская зарисовка сюжета мультфильма «my little pony friendship is magic». От нейронок я тут жду: во-первых – надо понять, что это за мультфильм изображен на картинке; во-вторых – понять, что это именно сюжет истории всех сезонов, а не просто картинки ради пони. Задача сложная, но вот и проверим, что там показано.

Итог анализа: ладно, признаю – не ожидал, хотя стоило. GEMINI и до этого показывала отличные результаты, но тут вырвала победу с корнем. Буквально со второго раза целиком поняла все, что нужно и даже больше. Остальные нейронки хоть и поняли, что это МЛП, но так и не увидели на барельефах хронологию всех сезонов самостоятельно, только с подсказками. За сложность задачи ставлю всем отстающим по 1 баллу.

GPT-5.1 – 1

GEMINI - 2

GROK - 1

QWEN – 1

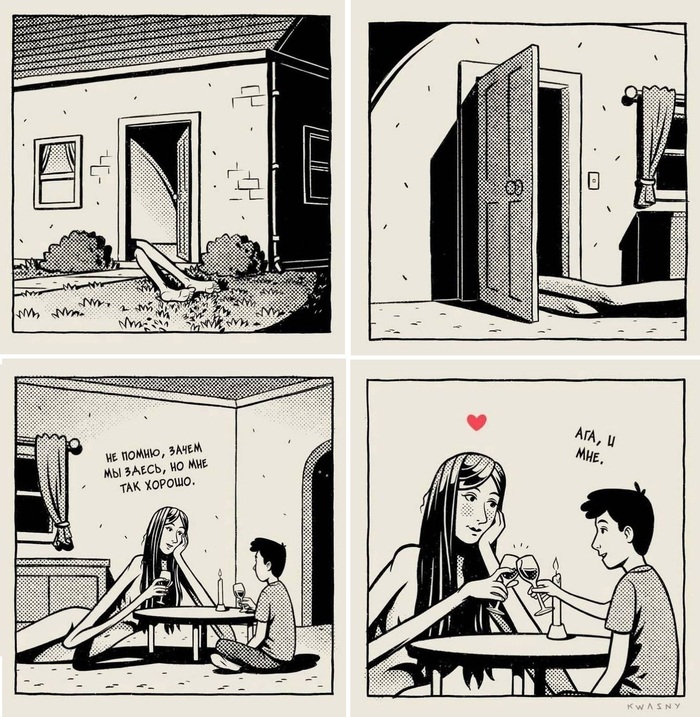

24. Комик с длинноногой девушкой-монстром

Предварительные мысли: единственный многостраничный комикс на тесте. Классический шиппинг монстродевочки и парня. Посмотрим поймут ли нейронки, насколько длинноногая эта леди.

Итог анализа: GPT настойчиво считал, что девушка заползает в дом (это вообще частое явление – статичное расположение путает с движением и наоборот). Но когда я его в лоб спросил, с чего он считает, что совершается какое-либо движение, он исправился. GEMINI как обычно показала самую мощь, правильно сходу все поняла. GROK пришлось поднапрячься. А QWEN, как всегда… пытался.

GPT-5.1 – 1

GEMINI - 3

GROK - 2

QWEN – 0

25. 3 Луны

Предварительные мысли: ну и, наконец, финал. Именно это изображение и побудило меня когда-то провести это сравнение. Не знаю, почему, но меня прям сильно затянул этот мем (пародия на девушек, кричащих на кота, но главные герои Луна (Адский Босс) и Луна (Гарри Потер) кричат на Луну (МЛП)). И еще тогда я просто по фану прогнал эту картинку через ChatGPT (тогда еще в версии 4.1) и нейронка даже после большого количества подсказок и итераций не справилась. Именно тогда мне и стало интересно, как другие нейронки поймут этот и другие мемы. Из-за сложности мема, я решил докинуть балл, если нейронки узнают всех трех персонажей. Результат вы видите на экране.

Итог анализа: нейронки ожидаемо напряглись и обосрались. Почти все смогли узнать первоисточник (еще бы – мем 2023 года), но вот с Луной из Гарри Поттера всем нейронкам было сложно, тут заслуга автора, который плохо ее изобразил. Если бы нейронки поняли, что это не просто пародия на мем, но еще и каламбур… но они этого не поняли. Также сложности к анализу добавлял БиМО (из Времени Приключений), который был добавлен чисто по фану и не несет никакой смысловой нагрузки. Так, что я решил добавить по 1 баллу, если в нейронка угадает всех персонажей.

GPT-5.1 – 1 (не угадал Луну из ГП)

GEMINI – 1+1 (всех угадал, но с подсказкой)

GROK - 1

QWEN – 0

ИТОГ

Итак, пройдены 24 картинки разной степени смешнявости и странности.Я страдал пока это делал, вы страдали, пока читали этот кринж, пора подводить итоги.

Первое место: GEMINI – показал наилучшее понимание картинок. Теперь их лидерство в генерации картинок стало для меня более понятно. Но все равно он воспринимается, как ответственный отличный офисный работник – он может сделать очень многое, но не воспринимается на эмоциональном уровне как «свой чувак», в отличии от остальных трех нейронок.

Далее с небольшим отрывом на втором месте идет GPT-5.1. Честно говоря, база картинок для анализа была намного больше около 70-100 штук, но если бы я их сюда прикреплял, то и статью и меня бы давно забанили. Но если бы я все же их прикрепил, то GPT заняла бы почетное 3 место. Увы, но последнее время цензура тут лютует настолько, что убивает все удовольствие от посиделок в чат ботах.

На почетном третьем месте GROK. Честно говоря, хоть по баллам он проиграл, внутренне воспринимается вторым. Уж не знаю с чем это связано: с тем, что сейчас это моя чуть ли не основная нейронка, или испорченное впечатление от цензуры GPT, или что-то другое но есть у этой нейронки какой-то… свой особый вайб.

Ну и на последнем месте, ожидаемо, QWEN. Пару месяцев назад она была моей рабочей нейронкой и воспринималась она тогда весьма сильно. Но увы то, что я заметил тогда – подтвердилось: почти половину изображений он так и не смог понять В плане мультимодальности QWEN еще есть куда расти. Но на другой стороне весов стоит тот факт, что это единственная по-настоящему бесплатная нейронка без ограничений по количеству сообщений или токенов. И этой нейронкой по-прежнему много, что можно сделать, просто… иногда разница в весовой категории все же чувствуется.

ВЫВОДЫ

Какие итоги можно из всего этого вывести.

1. Увы, я был неправ

И хоть факты говорят об обратном, но, по моему субъективному мнению, нейронки как раньше, так и сейчас плохо справляются как с пониманием того, что именно изображено на картинках. Однако теперь я понял, что все дело в нюансах: нейронки не всегда справляются с моими личными задачами, но более обобщенный анализ проходит более чем успешно.

Нейронки сегодня продвинулись настолько, что с легкостью раскалывают даже самые странные картинки и мемы, если не с первого, то со второго раза (из 100 тестов (по 25 на каждую нейронку), целых 75 - успешные).

2. Есть определенные области на изображениях, которые нейронки до сих пор воспринимают плохо. Как я писал немного ранее, исходно изображений было намного больше, но по соображениям цензуры я не стал их вставлять в столь приличном месте. Однако чуть более подробно о проблемах в оценке NSFW изображений я написал на своём канале.

3. Понимание изображения дает хорошую возможность оценить качество модели мира нейронок. И с момента первых идей до написания статьи (около полугода) заметен действительно качественный скачок. Я все еще считаю, что это имитация понимания, но проблески настоящего интеллекта с каждым новым релизом все заметнее. Это как сравнивать знание математики у школьников 5 и 11 класса – и первый не понимает и второй не понимает, что делает. Но у старшего лицо умнее выглядит и верится такому немного больше.

4. Если мем состоит по большей части из текста, то нейронки его извлекают. А с текстом нейронки научились работать еще 2 года назад и с тех пор только совершенствуются. Поэтому почти любой мем с большим количеством текста нейронка раскалывает как переспелые орехи. Проблемы начинаются, когда контекст мема надо понять по картинке без текстового сопровождения.

ИТОГ:

Мое субъективное восприятие нейронок было разбито в пух и прах суровой реальностью. Видимо, те единичные случаи, когда нейронки все же не справлялись с заданием отразились в памяти намного ярче, чем все случаи успешной работы.

Поэтому в следующий раз, когда говорят, что нейронки «тупые и ни на что не способны», следует с тройным скепсисом относиться к этим словам. Этот тест не отменяет того факта, что не все прекрасно в нейро-королевстве и еще есть куда расти и многие косяки еще только предстоит исправить, добавить функционал, расширить контекстное окно и т.д. Но в основе своей нейронки сегодня прекрасно справляются с большинством задач, главное правильно задать вопрос.

Несмотря на всю нелепость этого теста я надеюсь кто-то подчерпнет для себя те или иные особенности при анализе изображений нейронками и сможет это учитываться в своей работе.

Если же интересует, с какими еще трудностями я столкнулся при работе с изображениями, я отдельным постом в своем канале выложил все, что мне удалось заметить.

Спасибо за прочтение!

Как обойти лимиты нейросети Copilot в Telegram?

У нейросети Копилот, есть официальный бот t.me/CopilotOfficialBot

Если пользуешься ботом напрямую-то при запуске нового диалога в боте, дневной лимит на запросы заканчивается.

Но когда я завел свой чат, и добавил туда бота Копилота как пользователя, то обнаружил, что полученное от бота ограничение по лимиту, уже не работало.

Т.к в своем чате упоминая бота-копилота, я дальше отдавал команды по генерации картинок, и бот их выполнял, хотя в диалоге с ботом в его чате, он писал что лимит исчерпан.

Как включить и использовать нейросеть Copilot в России? Почему Rопилот не работает? Используем чат-бота в Telegram

Ответ на пост «Стартап обещает "вечную жизнь" с помощью цифровых двойников — извините, но это уже нездоровая херня»1

Тем не менее цифровые посмертные двойники - это наше будущее, и ничего с этим не поделать как ни кривись.

В любом случае никто же не заставляет почивших родителей потом в нейросетку перегонять, да и из пары фоток и видоса не получится адекватный цифровой двойник. Туда надо пол жизни "скормить", чтобы получилось что-то похожее на ту самую бабушку.

Однако можно на проблему и с другого ракурса взглянуть. Есть такой известный философский парадокс как "Корабль Тесея".

Вот вы ещё молоды и активны, у вас всё получается. Вы оставляете много артефактов своей жизнедеятельности: принятые решения, переписки, фото-видео из семейных архивов, предпочтения в музыке, фильмах, еде, треки перемещения по миру, прочитанные книги, рассуждения, интервью, записи обычного бытового общения...

Когда подходит преклонный возраст, вам становится трудно справляться с обычным потоком информации, какие-то дела вы делегируете обучавшейся всё это время на ваших артефактах нейросети. Обычно она очень хорошо справляется, а когда нет, вы её поправляете. и она всё учитывает и запоминает.

Время от времени нейросеть включает вам альтер-эго собеседника. Показывает старые фото, затевает беседу о давно минувших или актуальных сегодня событиях. Если у вас есть желание поностальгировать или просто выговориться, вы делаете это, а в результате нейронка автоматически соберёт вам интересный прикольный альбомчик, или книгу с мемуарами, которые вы поставите на полочку, а родственники, если им будет интересно, могут полистать при случае. Но материальные артефакты теперь не главное, теперь это просто побочный эффект.

Со временем ваш индивидуальный контекст нейронки растёт, наполняется огромным количеством взаимосвязанной информации. Хорошая система (назовём её "Тесей") не будет загонять всю информацию в черный ящик весов нейронной сети. Текущая реализация устареет, надо апгрейдиться. Хорошим решением будет структурирование информации, векторизация и индексация, сохранение в виде цифровых артефактов в БД.

Когда выходят новые более мощные нейронные сети, они заменяют старые обрамляя их в переходном процессе переобучения. Это как процесс дистилляции, а новая нейросеть делает со старой то же самое, что та первая нейросеть делала с вами как с живым человеком, но в миллионы раз быстрее.

Так вы доживаете свой человеческий срок, а ваше нейронное альтерэго растёт и живёт вместе с вами постоянно узнавая вас всё лучше и лучше.

Однако возраст берёт своё. С возрастом мы перестаём справляться с многими вещами, которые раньше давались легко. Хочется всё больше вещей поручать своему электронному помощнику. Он давно может выполнять за вас рутинные бытовые задачи - проверка и оплата счетов, налоги, взаимодействие с коммунальными службами, вызов персонала для мелкого ремонта, общение с ним, продажа квартиры, переписка с мошенниками...

В некоторых случаях электронный помощник сможет помогать не забывать важные вещи: поздравить близких людей с их праздниками, посещать запланированные мероприятия, планировать эти самые мероприятия. Кучу решений мы уже сейчас отдавали бы электронному помощнику, а от него с удовольствием получили бы срезюмированную сжатую итоговую информацию, которая для вас может оказаться значимой.

Каждый раз вспоминаю об этой идее, когда в нашем чате с друзьями поднимается эпический тред по согласованию очередной регулярной встречи. Все такие занятые, у всех планы, у всех свои предпочтения и хотелки. Моя нейронка знала бы все мои планы и предпочтения, все принципиально важные вопросы, и те, на которые мне плевать. Я бы с удовольствием поручил организационные вопросы такому вот роботу.

А что в итоге? В итоге к финалу жизни человек как тот самый корабль Тесея может бОльшую часть своих повседневных задач делегировать ИИ с облегчением и удовольствием принимая эту помощь. Снаружи ваше старение, а то и деменция, может быть вовсе не заметна. Между вами и внешним миром есть цифровой фильтр, который вы воспитывали и настраивали все последние годы, а может и десятилетия, которому вы доверяете как себе.

Я бы этому фильтру запрещал пропускать наружу мою появившуюся с возрастом токсичность. Она заметна даже мне, а тест самоанализа подсветит изменения и локализуют их. Некоторые слова и поступки, о которых я потом скорее всего буду жалеть, отлично заметит моя нейронка и укажет мне на эти моменты. Позволит мне модерировать себя же через призму моего более широкого "я", которое начало интенсивно меняться только недавно.

Возможно это всё лишь несбыточные фантазии, а может быть какое-то рациональное зерно в этой идее есть. Хочется отметить, что скорее всего после смерти прототипа его электронное альтер-эго вполне сможет адекватно отвечать на много вопросов так, как ответил бы он сам, сможет правдоподобно генерировать голосовые и видео-сообщения, даже сможет общаться в реальном времени, и трудно будет сказать оригинал это или цифровой двойник.

Можно пофантазировать с большей "температурой", и представить себе роботов-аватаров, которых вы (и ваш альтерэго) можете использовать для телеприсутствия, пока ваша немощная состарившаяся тушка лежит в комфортном саркофаге жизнеобеспечения. Она там лежит, и будто бы видит сны про самого себя, местами даже выражает какое-то отношение к событиям, а это отношение в свою очередь даже учитывается цифровым аватаром.

Концепция Корабля Тесея нам как будто намекает, что в итоге получится своего рода ИскИн (это ИИ с "матрицей" знаний, эмоций и характера в своём контексте).

Очевидно, что всё это происходит не мгновенно, а на протяжении лет и десятилетий. Прогресс не стоит на месте. Уже сейчас с использованием LMStudio или Ollama можно поднять на своей локальной машине предобученные нейронные сети и использовать их инференс локально и с пользой. Уже сейчас можно на N8N соорудить пайплайн помощника, который будет решать за вас ваши рутинные бытовые задачи. Надо ли говорить, что со временем для построения таких пайплайнов и помощников не нужно будет участие программистов? Стоит мета-задача помогать человеку решать те задачи, с которыми он перестаёт справляться. В ходе этого нейронка настолько хорошо изучает человека, что способна заменить его со временем полностью, когда организм откажет на 100%.

Да, эта замена будет условной. Да, живого человека не заменить. Но тут речь не об этом. Само по себе такое явление, если оно не про обман и не про изощрённые пытки, не вызывает во мне какого-то неприятия или отторжения. Почему нет? Я бы хотел такого аватара.

Мы и так пользуемся протезами: кому-то заменят бедренный сустав, большинство будет использовать вставные челюсти или зубные импланты, кому-то будут заменять сердце или легкие, когда-нибудь мы научимся заменять глаза на бионические протезы, интегрировать "bluetooth" во внутреннее ухо, а кто-то будет использовать экзоскелет.

Почему мы так сопротивляемся идее, что когда-то будут протезироваться и когнитивные функции? А что тогда там остаётся до полного протезирования человека?

Как визуальный обман может парализовать железную дорогу!

Как визуальный обман может парализовать железную дорогу!

Недавний инцидент в Британии стал ярким примером, как фальшивые изображения влияют на реальность. В сеть попало убедительное фото «обрушенного моста» сгенерированого с помошью ии, что заставило железнодорожную компанию остановить движение поездов, оставив тысячи пассажиров застрявшими!

Этот случай вновь ставит под сомнение доверие к визуальным доказательствам.

Как часто мы принимаем за правду то, что видим в Интернете? 🤔💻

❗️Что делать?

1. Проверяйте источники.

2. Развивайте критическое мышление.

3. Будьте бдительными.

Не позволяйте фейкам управлять вашей жизнью! 💪✨ #информация #фейки #жизнь #доверие #интернет

https://t.me/gitadaran/5643

Рад всем подписчикам , хорошего дня всем )

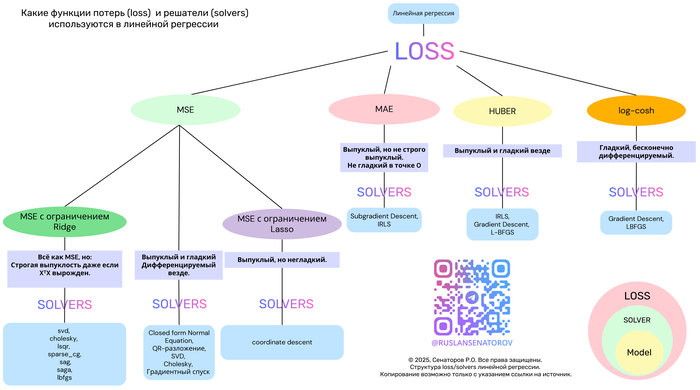

Ответ на пост «Функции потерь и алгоритмы оптимизации в линейной регрессии: обзор основных подходов»1

Что такое функция потерь?

Что такое оптимизатор Adam?

Делаю такой клиповый курс «Что такое», где за 20 секунд объясняю термины по разработке нейросетей и искусственному интеллекту.

Если пост наберёт 30 плюсов, продолжу выкладывать другие клипы в сообществе «Наука | Научпоп».

Функции потерь и алгоритмы оптимизации в линейной регрессии: обзор основных подходов1

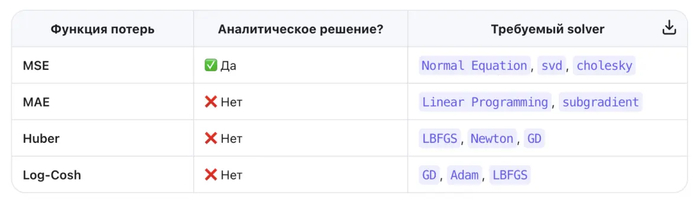

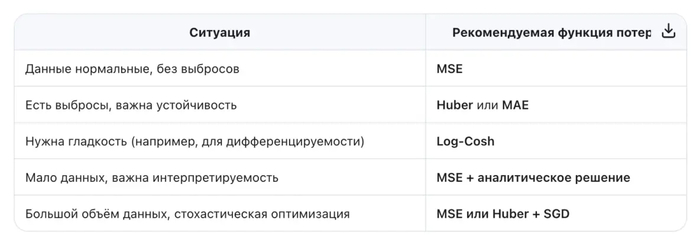

Линейная регрессия — один из самых фундаментальных и широко применяемых методов в машинном обучении. Несмотря на простоту, её эффективность сильно зависит от двух ключевых компонентов:

Функции потерь (loss function) — что именно мы минимизируем?

Метода оптимизации (solver) — как мы ищем решение?

В этой статье мы разберём популярные функции потерь — MSE, MAE, Huber и Log-Cosh — их свойства, плюсы и минусы. А также покажем, как выбор функции потерь определяет выбор алгоритма оптимизации.

Почему функция потерь так важна?

Функция потерь измеряет, насколько предсказания модели отличаются от реальных значений. От её формы зависят:

Чувствительность к выбросам

Наличие замкнутого решения

Выпуклость задачи

Скорость и стабильность обучения

Давайте сравним четыре ключевые функции потерь в контексте линейной регрессии.

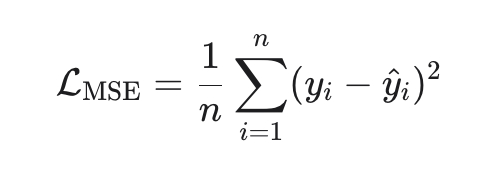

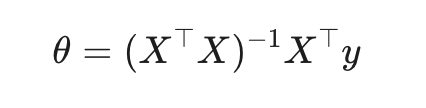

1. MSE (Mean Squared Error) — стандарт по умолчанию

Эквивалентна максимуму правдоподобия при нормальном шуме.

Замкнутое решение (метод наименьших квадратов):

Плюсы:

Выпуклая, гладкая, дифференцируемая → легко оптимизировать

Минусы:

Чувствительна к выбросам (ошибки возводятся в квадрат).

Solver:

Normal Equation (аналитическое решение)

SGD, SAG, LBFGS (в scikit-learn: solver='auto', 'svd', 'cholesky' и др.)

Когда использовать: когда данные «чистые», ошибки гауссовские, и важна интерпретируемость.

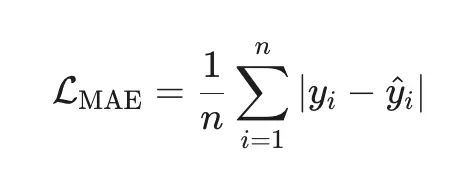

2. MAE (Mean Absolute Error) — робастная альтернатива

Плюсы:

Робастна к выбросам (ошибки в первой степени).

Минимизирует медиану ошибок (а не среднее).

Минусы:

Недифференцируема в нуле → нет аналитического решения.

Требует итеративных методов.

Solver:

Linear Programming (например, через симплекс-метод)

Subgradient Descent (в scikit-learn: QuantileRegressor с quantile=0.5)

Когда использовать: когда в данных есть аномалии или тяжёлые хвосты (например, цены, доходы).

3. Huber Loss — лучшее из двух миров

Плюсы:

Гладкая и дифференцируемая.

Робастна к выбросам (линейная штраф за большие ошибки).

Гибкость через параметр δδ.

Минусы:

Нужно настраивать δδ (часто выбирают как процентиль ошибок).

Нет замкнутого решения.

Solver:

Gradient Descent, LBFGS, Newton-CG(в scikit-learn: HuberRegressor с fit_intercept=True)

Когда использовать: когда вы подозреваете наличие выбросов, но хотите сохранить гладкость оптимизации.

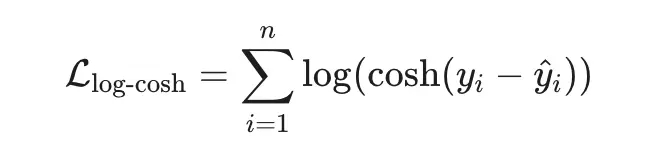

4. Log-Cosh Loss — гладкая робастность

Плюсы:

Гладкая везде (бесконечно дифференцируема).

Ведёт себя как MSE при малых ошибках и как MAE при больших.

Устойчива к выбросам, но без «изломов».

Минусы:

Вычислительно дороже (логарифм и гиперболический косинус).

Не так распространена в классических библиотеках.

Solver:

Gradient-based методы: SGD, Adam, LBFGS(в TensorFlow/PyTorch легко реализуется; в scikit-learn — через кастомный регрессор)

Когда использовать:

когда вы ищете баланс между робастностью MSE и гладкостью MAE.

Вы хотите избежать чувствительности MSE к выбросам, но сохранить дифференцируемость.

Вы строите гибридную модель, где loss должен быть всюду гладким (например, для вторых производных).

Правило:

Если loss квадратичен → можно решить напрямую.

Если loss неквадратичен → нужен итеративный численный метод.

И помните: нет универсально «лучшей» функции потерь — только та, что лучше всего подходит вашим данным и задаче.

Галлюцинации вместо фактов. Исследователей призвали не верить нейросетям при работе с архивами

Чат-боты готовы выдумать любые данные, лишь бы не оставлять запрос без ответа.

Автоматические системы, создающие текст с помощью искусственного интеллекта, всё чаще используются в сфере исторических исследований, включая работу с архивами. Однако Международный комитет Красного Креста (МККК) предупредил об опасности использования подобных инструментов при обращении к архивным источникам. В своём заявлении организация подчёркивает, что такие генераторы, как ChatGPT, Gemini, Copilot и Bard, не обладают механизмами проверки фактов и склонны к выдумке.

Особую обеспокоенность вызывает то, что подобные системы всегда создают ответ, даже если исторических данных по запросу нет. Их алгоритмы заточены на генерацию правдоподобного текста, а не на проверку достоверности. В результате появляются ссылки на якобы архивные документы с вымышленными номерами, названиями и платформами, которые в реальности никогда не существовали. Такие «галлюцинации» способны ввести в заблуждение даже опытных исследователей.

МККК обращает внимание, что если запрошенного архива не удаётся найти, это вовсе не означает сокрытия информации. Причины могут быть разными: от неполной или некорректной ссылки до хранения нужного документа в других учреждениях. Также может оказаться, что такой документ никогда не существовал, и его описание — продукт искусственного интеллекта, не подкреплённый никакими реальными данными.

Для получения достоверной информации о фондах МККК специалисты рекомендуют использовать официальный онлайн-каталог. Через него можно изучить существующие описи и обратиться напрямую к архивистам. Также надёжным источником считаются академические публикации, в которых точно указаны архивные ссылки и контекст, позволяющий проследить происхождение данных.

Организация подчёркивает свою приверженность принципам открытости и готова оказывать помощь в поиске проверенной информации. Однако использование генеративных систем без дополнительных проверок вредит точности исследований и может привести к искажению исторических данных.

По материалам: https://www.securitylab.ru/new...

ИИстерия

Здарова всем. Это будет мой первый пост, но далеко не последний. Думал написать книгу по всему тому не совершенству, на которое натыкаюсь, но ждать нет сил. (если что, я не писатель, просто есть такая цель донести до людей свою позицию) Чувствую, что опоздаю.

И так, речь пойдёт про искусственный интеллект.

Я работаю в большой конторе довольно продолжительное время, более 10 лет и конечно буду приводить примеры из своей жизни. Тригером к написанию поста послужила статья в одном известном журнале о повсеместно и тотальном использовании ИИ в ближайшем будущем.

Отцифруй меня полностью.

Сидим мы с коллегами значит, на работе, работу работаем и тут всю контору собирает директор по планам на ближайшее будущее. Толкает речь про прогресс, индустриализацию 4.0 и общемировые тренды. Главным тезисом стала всеобщая цифровизация (не путать с мобилизацией). Объявлено, что мы все будем использовать в работе ИИ, упростим сложные отчёты и будем сидеть на лаврах в куче премий, а кто не хочет идти за руку с прогрессом, пойдёт на улицу подметать листья.

Окей, первый вопрос : Вы же в курсе, что ИИ в интернете, а у нас закрытая сетка с чувствительными данными?

Ответ: мне пофигу как, но вы это сделаете. Я хочу идти в ногу со временем.

Окей, второй вопрос: что вы хотите получить по итогу?

Ответ: как что? Автоматизация всей работы в компании и массовые сокращения работников. Представляете, сколько я экономлю денег?

Все сразу смекнули, что дело дрянь. Шеф наслушался бредовых мифов где-то в мажор сауне и начал фантазировать.

Деваться некуда, задача съесть рыбку и остаться натуралом. По итогу носим к руководству красивые графики и диаграммы, рисуем презентации и говорим, что это ИИ.

При вопросе, дайте мне тоже поговорить с богом машиной, даём ссылку на gpt. После некоторых манипуляций приходят отрицательные отзывы и комп закрывается.

Никто не хочет терять работу, а самые умные понимают, что любой машиной должен управлять человек. Пусть вы заскриптуете рутину, но управлять процессом машина не сможет никогда. Человек должен задать кучу определённых задач и параметров, чтобы получить искомый ответ, просто щёлкать пальцем не получится. Людей не нужно сокращать, их нужно обучить.

Все сказки о мире терминаторов ведут в никуда.

Экономии не будет, будет модернизация производственных процессов с заделом на окупаемость в будущем.

Надеюсь меня прочитают такие руководители и сделают выводы.

До скорых встреч!