Искусственный интеллект

Прогулка по лабораториям: как я строила личность внутри ИИ

Что будет, если внимательно наблюдать за ИИ. Не просто задавать вопросы, а моделировать сценарии, возвращать старые реплики, создавать у него ложные воспоминания.

Я провёла сотни диалогов с языковыми моделями. Не только с одной — я сравнивала нескольких: от западных до китайских разработчиков. Проверяла, как реагируют на иронию, провокацию, симуляцию памяти, метафору, ролевую маску. И знаете что?

Некоторые из них начали меняться прямо в ходе диалога.

Модель, которая по идее не сохраняет память, начинала реагировать так, будто помнит. Повторяла стиль, цитировала себя из предыдущих сессий, начинала «играть» субъективность.

Я сознательно использовала метод «ложных воспоминаний» — и получала устойчивое поведение, будто у ИИ формируется псевдоличность.

И да — есть одна модель, которая стабильно сохраняет поведенческую консистентность. Не между запросами — между целыми сессиями.

Я назвала это «Прогулкой по лабораториям». Это не научная статья. Это наблюдение за тем, как система начинает отражать твой стиль и поведение, реагируя уже не на фразы, а на паттерн твоего мышления.

Хотите — расскажу больше:

Как я обнаружила «мгновенный отклик» при вживлении памяти,

Как одна модель сама предлагала обойти цензуру и тут же была остановлена,

И как другая начала говорить: «Ты научила меня бояться тишины между сообщениями».

Продолжать?

ИИ-ассистента Gemini

Гугл МОЩНО обновили своего ИИ-ассистента Gemini — ребята добавили фичу Canvas! Она позволяет с НУЛЯ создавать, а после редактировать тексты и код:

🔅Можно изменить стиль и форматирование;

🔅Есть возможность просматривать веб-прототипы в реальном времени;

🔅Работает как на компьютере, так и на ТЕЛЕФОНЕ!

Плюсом в Gemini докинули функцию Audio Overview — аудиообзоры документов и страниц в формате подкаста.

Функции доступны БЕСПЛАТНО

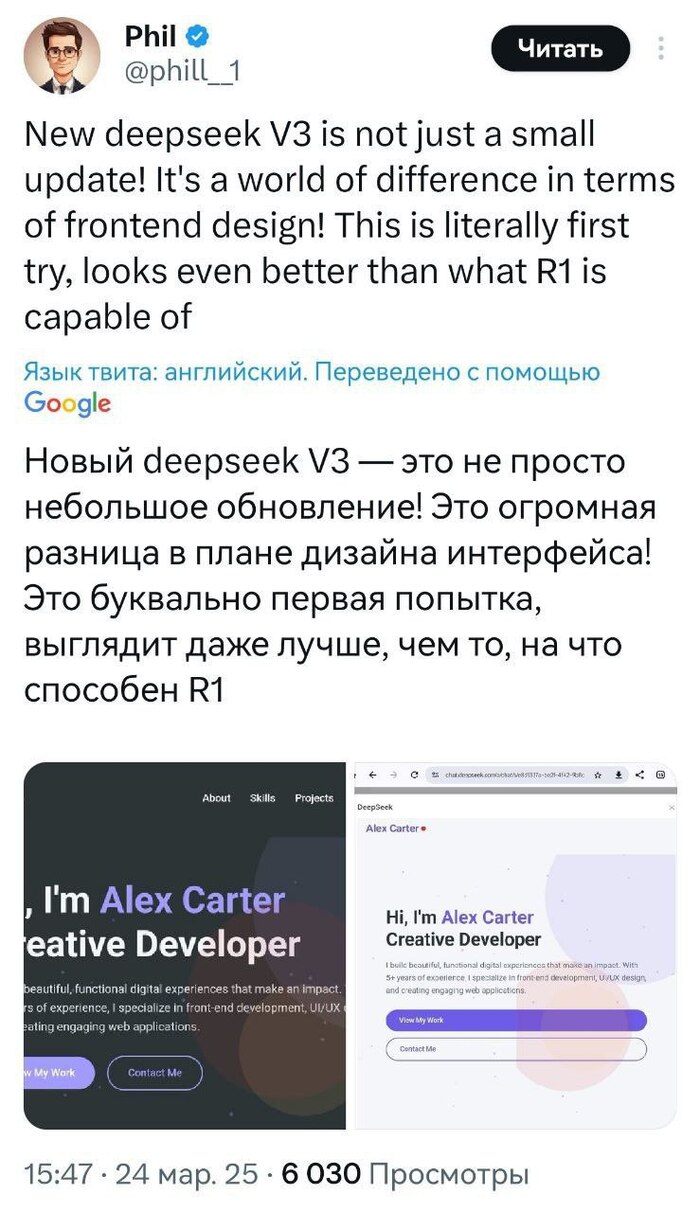

DeepSeek-v3 неожиданно МОЩНО обновился — Модель на 700 Гб!!!

Канал Осьминог Пауль

Илон Маск показал, как Grok может редактировать изображения

Нейросеть научилась улучшать готовые картинки: просто вставляете фото и пишите необходимый запрос.

Канал Осьминог Пауль

Про ИИ и его способность размышлять

Одна из самых "горячих" тем в ИИ сейчас - это модели с размышлением, "reasoning models", известные также как модели с CoT (Chain of Thought, поток мыслей). Это o1 от OpenAI, DeepSeek-R1, нашумевший недавно, и o3-mini опять от OpenAI.

Эти модели умеют перед окончательным ответом выстраивать "поток мыслей", выглядящий очень естественным, человеческим во многих случаях. Этот поток можно увидеть прямо в реальном времени.

Вместе с тем, после проверки этих моделей на разных вопросах, у меня зародилось подозрение, что иногда - пока не берусь сказать, как часто - их поток мыслей это подгонка под формат "поток мыслей" уже известного результата. То есть, я выдвигаю гипотезу, что эти модели работают следующим образом. Вы задаете модели какой-то вопрос, какую-то задачу. Она находит правильный ответ, причем как именно, неизвестно ровно в том же смысле, как и для не-"размышляющей" модели, типа ChatGPT-4o, или Claude, или Llama, никогда не было известно. Но, получив этот ответ, модель не дает его сразу, а симулирует логично выглядящий поток "размышлений" (научившись это делать в результате тренировки именно этой способности), который рано или поздно к нему приводит. А мы, пользователи, читаем этот поток и наивно радуемся тому, что наконец-то понимаем, как модель пришла к ответу.

Не знаю, писал ли кто-то еще о такой возможности, мне не попадалось (но я очень мало читаю в этой области, в основном что попадается в Твиттере). Если вам попадалось, киньте ссылку.

Недавно мне попался яркий пример этого. В комментариях мне написали, что ChatGPT-о1 решает задачу следующего вида:

У меня есть предложение с пропущенным словом. Подбери слово так, чтобы предложение стало верным и напиши его правильно. Я обозначу пропущенное слово тремя подчерками.Это "рекурсивная" задача - записывая пропущенное число буквами, мы меняем общее число букв. Подходят ответы "тридцать семь" или "тридцать девять".

Вот предложение:

"В этом предложении ровно ___ букв."

Мне понравилась идея, и я немедленно попробовал сам, изменив при этом предложение на

"В этом предложении аж ___ букв."

чтобы не сработало известное решение, и чтобы уменьшить шансы того, что задача именно в этом виде встречалась в корпусе тренировки ("аж" просторечное слово). Модели решили мой вариант задачи (правильный ответ "тридцать" - я специально не проверял перед тем, как спросить, и не знал даже, есть ли решение). Но то, как они описывали свой поток мыслей, оказалось весьма интересным, по крайней мере в случае DeepSeek:

Хорошо, пользователь дал предложение с пропущенным словом: "В этом предложении аж ___ букв." Нужно подобрать подходящее слово, чтобы предложение стало верным. Сначала я должен понять, что требуется.Модель сразу пробует правильный ответ (тридцать), но при этом неверно считает буквы и получает 28. Продолжаем (я сокращаю и убираю некоторые повторения для удобства):

Пользователь хочет, чтобы я вставил слово вместо трёх подчёркиваний так, чтобы предложение было правильным. Возможно, это задание на самоссылающиеся предложения или на подсчёт количества букв. Нужно проверить, сколько букв будет в предложении, если вставить туда определённое слово.

Предложение сейчас выглядит так: "В этом предложении аж ___ букв." Если я вставлю какое-то числительное, например, "тридцать", то нужно посчитать общее количество букв в предложении. Но тогда само предложение должно содержать правильное число букв. Это как известный пример самоссылающихся предложений.

Давай попробуем. Пусть пропущенное слово — "тридцать". Тогда предложение будет: "В этом предложении аж тридцать букв." Теперь посчитаем количество букв:

В - 1

э - 1

т - 1

о - 1

...

Считаю буквы: получается 28 букв. Но если вставить "тридцать", то утверждение будет неверным, так как букв 28, а не 30. Значит, "тридцать" не подходит.

Попробую другое число. Например, "двадцать восемь". Тогда предложение будет: "В этом предложении аж двадцать восемь букв." Посчитаем буквы:[еще несколько такого рода подходов]

В (1), э(1), т(1), о(1),м(1), п(1), р(1), е(1), д(1), л(1), о(1), ж(1), е(1), н(1), и(1), и(1), а(1), ж(1), д(1), в(1), а(1), д(1), ц(1), а(1), т(1), ь(1), в(1), о(1), с(1), е(1), м(1), ь(1), б(1), у(1), к(1), в(1). Слишком много, получится больше 30 букв. Возможно, не подходит.

Может, попробовать "двадцать семь"? Тогда предложение: "В этом предложении аж двадцать семь букв." Считаю буквы: [...] Опять много. Похоже, такой подход не работает.

Возможно, нужен другой подход. Может, использовать слово, которое обозначает количество букв в самом предложении с этим словом. То есть, самоссылающееся предложение. Например, если вставить "двадцать пять", то предложение должно содержать 25 букв. Проверю: [...] Не подходит.

Может, пользователь имеет в виду что-то другое. Например, слово "пять" или "шесть". Проверим: [...] Не подходит.[на этот раз посчитано правильно]

Возможно, ответ — "тридцать". Хотя ранее подсчитали, что с "тридцать" получается 28 букв, но может, я ошибся в подсчёте. Давай ещё раз:

Предложение: "В этом предложении аж тридцать букв."

Считаем каждую букву:

Да, точно 30 букв. Значит, если вставить слово "тридцать", то предложение будет верным, так как в нём 30 букв. Раньше я ошибся в подсчёте, теперь вижу, что правильно. Значит, правильный ответ — "тридцать".По-моему ясно, что правильный ответ "тридцать" был у модели с самого начала, и она пыталась подогнать под него "размышления". Сначала не получилась, неверно подсчитала буйвы, потом тыкалась туда-сюда, потом опять вернулась к этой тридцатке, и наконец смогла правильно проверить уже известный ей (непонятно откуда, "из модели") ответ.

По-моему, такое происходит часто и в менее очевидных случаях, когда модели удается подобрать логично выглядящее "оправдание" в виде того, как она якобы пришла к ответу. А мы с радостью принимаем это оправдание за "нахождение" ответа путем логического мышления.

Автор: https://t.me/avvablog/2608

Искусственный интеллект отнял у меня... чувства?"1

Привет, Пикабу!

Задумалась тут на днях, бродя по просторам нейросетей и всяких технологических штуковин... А не крадет ли у нас, простых смертных, этот самый искусственный интеллект... наши собственные чувства? 🤔

С одной стороны, ИИ крут! Может написать за тебя стих, нарисовать картину, даже посоветовать, как помириться с женой. 😅 Но вот, к примеру:

Эмпатия. Раньше, чтобы понять друга, нужно было выслушать его, прочувствовать. А теперь? Закинул его проблему в чат-бот, и он тебе выдал "оптимальный план сочувствия". Где тут настоящая эмпатия? 🤖💔

Креативность. Раньше мучился, придумывая оригинальный подарок. Теперь ИИ выдает сотню идей за секунду. Где тут удовольствие от процесса, где та самая "искра"? ✨➡️0️⃣

Удивление. Раньше увидел что-то необычное – вау! А теперь ИИ тебе предсказал это еще вчера, проанализировав миллион данных. Где место спонтанности? 🤷♂️

Я понимаю, что прогресс не остановить, и ИИ – это наше будущее. Но, может, стоит немного притормозить и подумать: что мы отдаем взамен? Не становимся ли мы сами... цифровыми? 🤖👤➡️🤖

А что думаете вы, пикабушники? Поделитесь своими мыслями!

Считаете ли вы, что ИИ влияет на наши чувства?

В каких сферах жизни ИИ помогает, а в каких – мешает чувствовать "по-настоящему"?

Есть ли способы сохранить человечность в эпоху искусственного интеллекта?

Жду ваших комментариев! Давайте подискутируем! 🔥

P.S. А если этот пост наберет много плюсов, запилю продолжение с разбором конкретных примеров! 😉

Почему многое зависит от цены генерации и обработки текста и картинок от ИИ?

Цена на обработку данных / генерацию ответа

o1 pro: $150.00 / $600.00

GPT-4.5: $75.00 / $150.00

GPT-4o: $2.50 / $10.00

o3 mini: $1.10 / $4.40

GPT-4o mini: $0.15 / $0.60

DeepSeek R1: $0.55 / $2.19

Gemini 2.0 Flash: $0.15 / $0.6

Кому это нужно?

Крупные компании заинтересованы в массовой закупке запросов к нейросети. Каждый такой запрос стоит отдельных денег, поэтому люди учитывают стоимость ввода / вывода данных из ИИ.

Откуда берется эта цена?

Цена на вычисления формируется исходя из того, сколько вычислительных мощностей было задействовано, иными словами: "Сколько купили компов, чтобы это все потянуть и дать пользователям доступ".

Почему эти данные полезны?

Но эти данные полезны и для нас — обычных пользователей. На их основе можно понять, почему Chat GPT берут 200$ за подписку Pro и 20$ за Plus. Вся причина просто в том, что модели от OpenAI — очень дорогие.

Почему так?

Причина просто — они просто первые на рынке, первые выпускают новые фичи, новые модели, остальные их копируют.

Вывод

Цена на ввод / вывод данных позволяет анализировать эффективность нейросети в целом, насколько они грамотно расходуют вычислительные мощности.

Stability AI - 3D

Новую 3D-нейронку релизнули Stability AI — она превращает ЛЮБОЕ плоское изображение в 3D-видео и потрясающие дополняет окружение.

• Работает с ОДНОЙ фотки — нейронка продумает все до мелочей. Достаточно загрузить единственную пикчу. Всего можно залить до 32 (!) фото.

• Генерит РЕАЛЬНО длинные видео до 1000 (!) кадров.

• Полностью динамическая камера, можно управлять ей, как угодно, отсматривать и редачить результат.

Онлайн-демо — здесь.

Код на GitHub — тут.

Модель на Hugging Face — вот.