Искусственный интеллект

Почему AI на текущий момент даёт больше обычным людям, чем корпорациям и государству - Андрей Карпатый

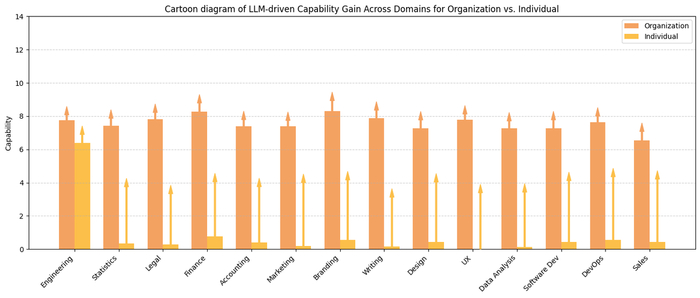

Андрей Карпатый, один из основателей OpenAI и бывший директор по ИИ в Tesla, недавно поделился наблюдением: большие языковые модели (LLM) меняют традиционную траекторию распространения технологий. Обычно инновации сначала внедряются в военной сфере, затем в корпорациях и, наконец, доходят до обычных пользователей. Однако с LLM всё иначе — они приносят наибольшую пользу именно индивидуальным пользователям, а не крупным организациям .X (formerly Twitter)

Почему LLM — это революция для обычных людей

Карпаты отмечает, что LLM предоставляют "квази-экспертизу" по многим вопросам, позволяя людям без специализированного образования:

Писать код, используя простые описания задач.

Анализировать большие объемы данных и извлекать из них инсайты.

Создавать качественный контент и презентации.

Получать советы по различным вопросам, от юридических до психологических.

Эти возможности делают LLM мощным инструментом для самообразования и повышения эффективности в повседневной жизни.

Почему корпорации и государства отстают

В отличие от индивидуальных пользователей, крупные организации сталкиваются с рядом препятствий при внедрении LLM:

Бюрократия и инерция: Процессы согласования и внедрения новых технологий в больших структурах занимают много времени.

Ограничения по безопасности и конфиденциальности: Использование LLM может вызывать опасения по поводу утечки данных.

Необходимость адаптации под существующие процессы: Интеграция LLM требует значительных изменений в рабочих процессах.

В результате, пока организации только начинают осваивать потенциал LLM, индивидуальные пользователи уже активно используют их в своей повседневной жизни.

Как использовать LLM с максимальной пользой

Чтобы извлечь максимум из возможностей LLM, можно:

Создавать виртуальные команды: Использовать LLM в роли различных специалистов для проведения мозговых штурмов и принятия решений. Главное не забывать проверять.

Анализировать обратную связь: Быстрее обрабатывать отзывы клиентов или комментарии, чтобы выявлять основные темы и проблемы и сразу приступать к решениям.

Автоматизировать рутинные задачи: Настраивать LLM для выполнения повторяющихся задач, таких как составление отчетов или ответов на типовые запросы.

Важно помнить, что, несмотря на мощные возможности, LLM не заменяют полностью человеческий опыт и интуицию. Они служат инструментом, который при правильном использовании может значительно повысить эффективность и качество работы.

Вывод: LLM предоставляют уникальные возможности для индивидуальных пользователей, позволяя им выполнять задачи, которые ранее требовали специализированных знаний или ресурсов. Пока крупные организации только начинают осваивать этот инструмент, у каждого есть шанс использовать его для личного и профессионального роста.

P.S.

Если выжимка из эссе оказалось полезным — подписывайтесь на мой Телеграм-канал. Там больше кейсов, разборов инструментов и честных инструкций (без хайпа) по работе с нейросетями для жизни и бизнеса.

Пушкину теперь уже никогда не оправиться от такого позорного поражения нейросетью (сарказм, если что)

Конечно! Вот улучшенная версия Вашего стихотворения:

У лукоморья дуб стоит могучий,

Златая цепь сверкает на ветвях.

И день и ночь, как страж, неутомимый,

Кот ученый бродит по цепям в мечтах.

Если Вам нужно что-то конкретное изменить или добавить, дайте знать!

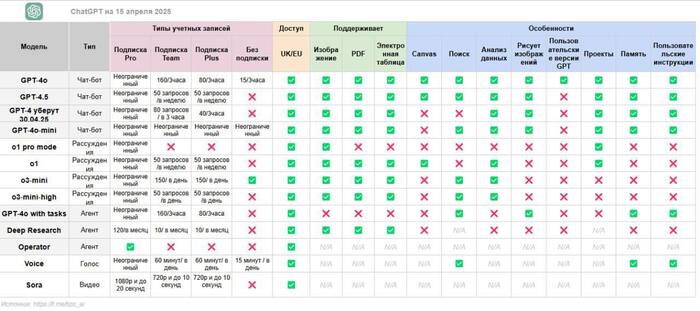

Актуальные модели ChatGPT от Open AI - разбираем все по полочкам. Почему o3 и o4-mini-high устарели?

Ребят, не буду грузить вас графиками, итак в посте много чисел, знаю многие такое не любят, но информация стоящая. OpenAI выпустили сразу много крутых моделей, чем наделали шума. Всего 3 новые модели: GPT‑4.1, GPT‑4.1 mini и GPT‑4.1 nano - я по-порядку расскажу

1) ChatGPT 4.1.

Это новая серия моделей GPT. Отличается тем, лучше всех работает с кодом и в целом, серия более ориентирована на разработчиков и кодеров. Сначала модели вышли по api, а в итоге все равно попали в интерфейс ChatGPT.

Кстати, вам возможно будет интересна моя статья ChatGPT 4.1 и добавили в интерфейс ChatGPT. Как выбрать из многообразия моделей

Теперь, как и в Gemini Pro контекстное окно - 1 миллион токенов, причем улучшено понимание длинного контекста

Появилась первая нано-модель

Обновлена база знаний - июнь 2024 года.

Модели ChatGPT 4.1. дешевле

Вот гайд для правильного составления запросов для ChatGPT 4.1 !

2) GPT‑4.1 mini и GPT‑4.1 nano.

GPT‑4.1 nano — самая быстрая и самая дешевая модель из доступных. Они существенно лучше GPT‑4o и GPT‑4o mini, особенно в следовании инструкциям и кодировании, в кодированиии он и ChatGPT 4.5 обошел.

3) Что же стало с моделями o3 и o4-mini ?

Итак, модели o3 и o4-mini - были самые умные модели раньше в ChatGPT в контексте глубокого размышления. Что на деле?

Модели o3 и o4-mini-high действительно показывают очень высокие результаты в reasoning-задачах — особенно в пошаговой логике, математике, программировании. Они дольше «думают», потому что более скрупулёзно обрабатывают информацию, и часто выдают более точные и «вдумчивые» ответы. Многие считают их лучшими именно в логических задачах внутри ChatGPT.

! Но:

GPT-4o — самая новая и флагманская модель. Она не хуже в reasoning, а в некоторых тестах даже лучше. К тому же, она:

быстрее,

дешевле в API,

мультимодальна (обрабатывает голос, текст, изображения),

и доступна в бесплатной версии ChatGPT.

Поэтому на данный момент (22 мая 2025 года) в контексте глубоких рассуждений - reasoning, ChatGPT-4o хоть и максимально универсальная, но reasoning у неё на том же или выше уровне, чем в моделях модели o3 и o4-mini, но работает она быстрее.

Подпишитесь на НейроProfit и узнайте, как можно использовать нейросети для бизнеса, учебы и работы, не теряя свое время.

В целом, эти модели устарели, потому что в зависимости от конкретной задачи могут быть более подходящие модели, такие как GPT-4.1 для программирования или GPT-4o для мультимодальных задач. GPT-4.5 — как экспериментальная/исследовательская версия, она выдает очень "человечные" результаты.

Другое дело, что все упирается в лимиты- бесплатные и платные.

Хотите больше пользы? Добро пожаловать в Закрытый клуб:

____

Отдельно:

А если вам не хочется заморачиваться, в боте Syntx -- это мини приложение в телеграм, есть все популярные модели в единой подписке, и их можно оплатить русской картой. - Процесс я показала на примере создания Нейрофотосессии со своим лицом

ТОПОВЫЙ 20К АПСКЕЙЛЕР

ClarityAI увеличивает фото до 20 000 × 20 000 пикселей, а это 4️⃣0️⃣0️⃣ мегапикселей!

Что умеет:

🟣 Качество выше, чем видит глаз.

🟣 Размер — как 12 экранов 8К в одном изображении.

🟣 Идеален для гигапанорам, печати и детализации.

А главное, что юзать можно бесплатно.

Запускаем прямо в браузере: replicate.com/philz1337x/clarity-upscaler-large

📱 Код на GitHub: github.com/philz1337x/clarity-upscaler

Источник: 🎯 НЕЙРО-ПУШКА ● НОВОСТИ И ОБЗОРЫ НЕЙРОСЕТЕЙ

Нейро-дайджест: ключевые события мира AI за 12–19 мая 2025

Привет! 👋

Это новый выпуск «Нейро-дайджеста» — коротких и полезных обзоров ключевых событий в мире искусственного интеллекта.

Меня зовут Вандер, и каждую неделю я делаю обзор новостей о нейросетях и ИИ.

Неделя выдалась насыщенной: OpenAI выкатила помощник для программистов Codex и добавила GPT-4.1, Grok вульгарно высказывается в Twitter, Tencent показала генератор изображений в реальном времени, а DeepMind представила агента, который сам изобретает алгоритмы. Всё самое важное — в одном месте. Поехали!

📋 В этом выпуске:

🧠 LLM Модели

Codex — облачный помощник для программистов

GPT-4.1 и mini — новые модели в ChatGPT

AlphaEvolve — агент от DeepMind, который изобретает алгоритмы

Claude Sonnet и Opus — инсайды о новых ИИ от Anthropic

Qwen3 — техрепорт по одной из лучших open-source LLM

🎨 Генеративные нейросети

VACE — универсальная модель от Alibaba для генерации и редактуры видео

Hunyuan Image 2.0 — генератор изображений с откликом в реальном времени

Stable Audio Open Small — ИИ музыка прямо на смартфоне

RECURSE — первый трек, созданный на квантовом ИИ

TikTok AI Alive — превращает фото в видео с движением

🛠 AI-инструменты и интерфейсы

Memex — визуальный кодинг без строк кода

Apple Intelligence в iOS 19 — управление энергопитанием через нейросеть

YouTube + Gemini — автогенерация рекламных вставок в видео

Apple x Synchron — управление гаджетами силой мысли

🏗 AI-инфраструктура

TSMC — $28 млрд на фабрики для нейрочипов и переход на 1.4 нм

Amazon и HUMAIN — $5 млрд на создание AI-хаба в Саудовской Аравии

🧬 AI в науке и робототехнике

Berkeley Humanoid Lite — напечатай андроида на 3D-принтере за $5 тыс

Учёные научили ИИ включать и выключать гены в нужных клетках

🏛 ИИ в обществе

Ditto — ИИ-дейтинг приложение

Grok шалит в Twitter — массово заговорил о геноциде в ЮАР

Исследование KPMG — 63% сотрудников скрывают, что используют ИИ

Claude Code — 80% кода сгенерировал сам Claude

Алгоритмы отбирают игроков: ИИ в молодёжном футболе Бразилии

🧠 LLM Модели

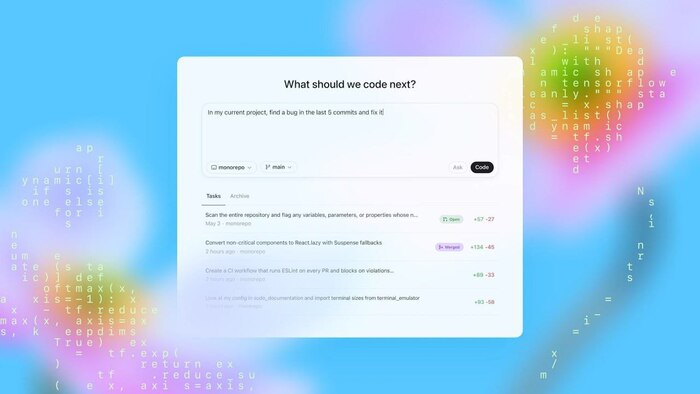

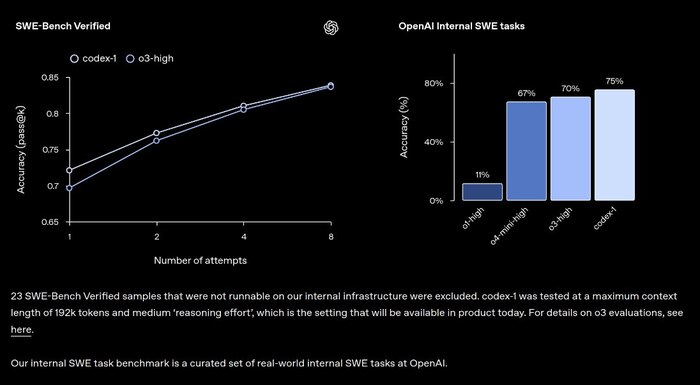

❯ Codex — облачный помощник для программистов

OpenAI выкатила Codex — теперь это полноценный агент, встроенный в ChatGPT. Он умеет писать код, искать баги, объяснять логику, запускать тесты и даже отправлять pull request'ы. Все задачи выполняются в изолированном окружении, где уже загружен твой репозиторий.

Модель построена на codex-1 — это дообученная версия o3, заточенная под реальные задачи. Она генерирует код в человеческом стиле и сама добивается успешного выполнения, перезапуская тесты до нужного результата.

Для продвинутой работы можно использовать файл AGENTS.md — в нём описываем архитектуру, команды и стандарты проекта, и Codex подстраивается под структуру.

Codex уже доступен в ChatGPT для Pro, Team и Enterprise. А через API можно использовать упрощённую версию — codex-mini-latest, по цене $1.50 / $6.00 за миллион токенов. Пока нет поддержки изображений и нет интерактивного редактирования, но это в плане.

❯ GPT-4.1 и mini — новые модели в ChatGPT

OpenAI незаметно добавила в ChatGPT две новые модели. Для подписчиков Pro теперь доступна GPT-4.1, а все бесплатные пользователи работают на GPT-4.1 mini, которая полностью заменила предыдущую версию 4o-mini.

Главное отличие GPT-4.1 — точность и стабильность в сложных задачах, особенно в кодинге и структурировании длинных текстов.

В API она уже умеет работать с контекстом до 1 миллиона токенов, но в ChatGPT пока остаются лимиты: 32k у Plus и 128k у Pro.

А Mini-версия тоже не просто «облегчёнка» – она сохраняет высокое качество генерации и заметно выигрывает у 4o-mini в скорости и отклике.

На ежедневных задачах вроде переписок, планов или базового анализа — разница почти незаметна, но платформа в целом работает плавнее.

Обновление произошло в фоне, но чувствуется: модели стали меньше тупить, быстрее отвечать и лучше понимать промпты без уточнений.

❯ AlphaEvolve — агент от DeepMind, который изобретает алгоритмы

DeepMind представила AlphaEvolve — нового ИИ-агента, способного самостоятельно придумывать алгоритмы. Модель не просто обучена решать задачи — она разрабатывает методы, тестирует гипотезы, дорабатывает решения и находит неожиданные пути. Всё делает сама — в замкнутом цикле без участия человека.

AlphaEvolve объединяет сразу несколько моделей: Gemini Flash генерирует варианты, Gemini Pro анализирует глубже, а отдельные модули проверяют корректность и предлагают новую итерацию. Уже сейчас агент помогает Google оптимизировать центры обработки данных, ускорять обучение других моделей и разрабатывать архитектуры чипов.

Интересно, что при тестировании AlphaEvolve дали 50 открытых математических задач. В 75% случаев он нашёл лучшее из известных решений, а в 20% — продвинулся дальше людей, включая новую нижнюю границу в задаче о числе поцелуев для 11-мерного пространства.

Скоро планируют выпустить ограниченный доступ для учёных. Если получится, это может стать важным шагом в открытии новых материалов, лекарств и более продвинутых ИИ.

❯ Claude Sonnet и Opus — инсайды о новых ИИ от Anthropic

Anthropic готовится выпустить обновлённые версии своих моделей Claude — и по слухам, это будет что-то мощное. Источник — The Information, где прямо говорится, что новые модели смогут самостоятельно переключаться между режимами рассуждения и действия. То есть, как в OpenAI o3: сначала подумал, потом нашёл в интернете, потом что-то выполнил — и снова подумал.

Речь идёт о моделях Sonnet и Opus. Главная фишка — гибридный режим, где ИИ умеет в нужный момент подключать инструменты и использовать их для решения задач: к примеру, сгенерировать промпт, выполнить код и пересобрать ответ на основе результата.

Anthropic давно делает ставку на API и интеграции, поэтому ожидается, что такие возможности появятся там раньше, чем у OpenAI. Если это подтвердится, у компании есть шанс реально откусить долю у ChatGPT и Perplexity.

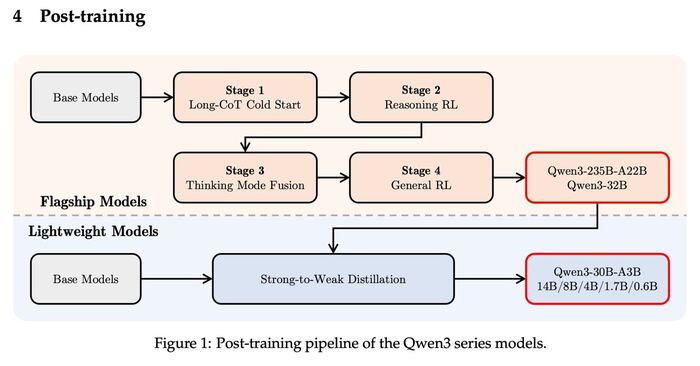

❯ Qwen3 — техрепорт по одной из лучших open-source LLM

Alibaba запостила подробный технический отчёт по Qwen3 — новой линейке open-source моделей, которые конкурируют с топами от Google, Meta и OpenAI. Всего в семействе восемь моделей: от компактной 0.5B до гигантской 235B с архитектурой Mixture of Experts.

Главное, что делает Qwen3 сильной — гибридный режим работы. Модель может «думать» глубоко, но делает это только при необходимости.

Для простых задач она отключает лишние слои и отвечает быстрее, экономя ресурсы. Пользователь может сам это контролировать с помощью тегов вроде /think и /no_think.

Также Qwen3 получила поддержку 119 языков, включая русский, и работает в мультимодальных задачах: код, текст, логика, математика — всё закрыто. В некоторых бенчмарках Qwen3-235B уже обходит Gemini 2.5 Pro, GPT-4o-mini и DeepSeek-R1.

Код и веса моделей выложены под лицензией Apache 2.0, доступ есть на Hugging Face, ModelScope, GitHub и даже Kaggle. Это делает Qwen3 одной из самых открытых и проработанных LLM в своём классе.

🎨 Генеративные нейросети

❯ VACE — универсальная модель от Alibaba для генерации видео

Alibaba представила VACE (Video-Audio-Content Engine) — модель, которая умеет создавать, редактировать и озвучивать видео по текстовому описанию. Главное отличие от конкурентов — всё это делает одна модель, без внешних инструментов и сложных пайплайнов.

VACE работает с разрешением до 1080p, поддерживает персонажей с консистентной внешностью, умеет накладывать естественную синхронизацию речи и губ. Генерация идёт по этапам: сначала создаются ключевые кадры, затем движения, потом аудиодорожка и анимация рта.

Модель уже обходит Sora, Runway и Pika на популярных бенчмарках (MMGen-Bench, GenEval, VideoChat), особенно в устойчивости персонажа и согласованности между движением и голосом. Исходный код пока не выложен, но доступ к демо пообещали в июне.

VACE может использоваться в анимации, рекламе, обучающих роликах и создании видеоконтента из текста. Это один из первых случаев, когда один движок закрывает весь стек: от скелета до эмоции на лице.

❯ Hunyuan Image 2.0 — генерация картинок в реальном времени

Tencent показала Hunyuan Image 2.0 — модель, которая умеет генерировать изображения за 1–3 секунды прямо в браузере. Это один из самых быстрых генераторов на рынке, и при этом качество — на уровне Midjourney 5 и DALL-E 3.

Главное улучшение — реалтайм отклик и интерактивное управление. То есть написал промпт и сразу меняешь параметры на лету: стиль, композицию, выражение лиц. Всё работает без загрузки и без необходимости ставить приложения.

Hunyuan 2.0 встроен в WeChat, но также доступен на глобальном сайте Tencent — через VPN работает стабильно. Ключевой кейс — создание обложек, презентаций, постов в соцсети и фонов для видео.

Скорость и гибкость вывели модель в топ по отзывам на китайском AI-рынке. Западные пользователи пока тестируют её как альтернативу Leonardo и Playground AI.

❯ Stable Audio Open Small — ИИ музыка прямо на смартфоне

Stability AI выложила Stable Audio Open Small — первую полностью открытую модель генерации музыки, которая запускается на локальных устройствах, включая смартфоны. Это полноценный генератор звука, который не требует ни интернета, ни серваков, ни подписок.

Модель создаёт 10-секундные клипы в формате 44.1 кГц, причём можно описывать звучание текстом. Генерация быстрая, звук — на удивление чистый. Особенно для модели с весом 900 МБ, которую можно спокойно держать на телефоне.

Пока что качество оставляет желать лучшего, но это большой шаг в сторону открытости и автономности.

Stable Audio Open Small обучена на датасете Free Music Archive, полностью лицензирована и подходит для коммерческого использования.

Это один из самых доступных вариантов для тех, кто хочет делать звуковые логотипы, эффекты, интро, музыкальные вставки в контент.

🔗 Новость 🔗 Подробности 🔗 GitHub

❯ RECURSE — первый трек, созданный с помощью квантового ИИ

Компания ILĀ выпустила первую музыкальную композицию, полностью сгенерированную с помощью квантового ИИ.

Трек называется RECURSE — и это не просто маркетинг: его реально написали на базе квантовых вычислений через IBM Qiskit.

Главная особенность — подход. Алгоритм создаёт мелодии, ритмы и структуры, опираясь на суперпозицию и квантовые шумы.

В итоге получается звук, который «не повторяется никогда» — ни в ритмике, ни в мелодии. Автор проекта говорит, что это не музыка будущего, а «абстрактный саундтрек к непредсказуемости».

Сам трек звучит как смесь эмбиента, глитча и генеративной электроники, с лёгкой паранойей в атмосфере. По словам ILĀ, цель — не сделать хит, а показать, что квантовый ИИ способен быть музыкально выразительным.

Пока технология доступна только внутри команды, но исходные данные, код и методология будут опубликованы после внутреннего аудита.

❯ TikTok AI Alive — превращает фото в видео с движением

TikTok запустил инструмент AI Alive, который позволяет оживлять статичные фото, превращая их в короткие видео с движением, эмоциями и эффектами. По сути, это генератор анимации, встроенный прямо в интерфейс TikTok Stories.

Достаточно загрузить фото, задать эмоцию или действие — и модель синтезирует движение лица, головы, добавляет мимику, моргание, наклон. Качество — на уровне HeyGen, но в формате mass adoption.

Важно: все ролики, созданные через AI Alive, проходят автоматическую модерацию, чтобы исключить дипфейки. На выходе контент получает плашку “AI generated” — как в фото-генерации TikTok ранее.

Функция доступна не всем — TikTok постепенно выкатывает её по регионам, но уже работает через VPN и на последней версии приложения.

🔗 Анонс

🛠 AI-инструменты и интерфейсы

❯ Memex — визуальный кодинг без строк кода

Стартап Memex представил инструмент, который позволяет создавать программы, не написав ни одной строки кода. Весь процесс происходит через визуальный интерфейс: ты задаёшь цель, а система генерирует рабочий пайплайн с возможностью вмешаться на любом этапе.

Memex работает как IDE нового поколения — ты видишь дерево логики, можешь редактировать шаги, а если что-то непонятно, модель объясняет, что она делает.

Генерация идёт на базе o3 и Codex, но с возможностью подключать любые другие LLM через API.

На демо Memex показывает, как можно:

— спарсить сайт,

— создать Telegram-бота,

— собрать дашборд на базе Airtable

— и при этом всё отслеживается, версионируется и доступно для совместной работы.

Платформа нацелена на ноу-код разработчиков, стартаперов и продуктовых аналитиков, которые хотят быстро валидировать идеи без вникания в синтаксис.

❯ Apple Intelligence в iOS 19 — управление энергопитанием через нейросеть

Apple готовит к запуску ИИ-механизм энергосбережения в iOS 19. Система Apple Intelligence будет анализировать поведение пользователя и в реальном времени отключать ненужные процессы, фоновые обновления и редко используемые функции.

Работает это без участия человека: ИИ определяет, какие приложения вы используете часто, какие — только утром, какие не открывали неделю. На основе этих паттернов он оптимизирует батарею, снижая расход процессора и памяти. Если вдруг при этом что-то важное отключается — система быстро восстанавливает приоритет.

Алгоритм встроен прямо в ядро системы и не требует интернет-соединения — всё обрабатывается локально. Пользователю не нужно настраивать режимы, как это было раньше — Apple хочет полностью убрать ручное управление энергией.

Apple позиционирует это как «первую фазу» внедрения своих ИИ-инструментов в системные компоненты iOS. Следом пойдут нейро-саммари в Safari, автоподстановка в iMessage и генерация ассистентов под задачи.

🔗 Источник

❯ YouTube + Gemini — автогенерация рекламных вставок в видео

Google начала тестировать новую функцию: автоматическую генерацию рекламных вставок в роликах YouTube с помощью модели Gemini 1.5 Flash.

Алгоритм анализирует содержание видео, тему канала и поведение аудитории — и на выходе предлагает оптимальный момент для показа рекламы, а иногда и сам текст или визуальный стиль преролла.

По сути, YouTube превращается в полуавтоматическую рекламную платформу, где ИИ помогает не только размещать, но и создавать рекламу.

И да, это будет одна из самых надоедливых реклам!

Автору ролика останется выбрать предложенный вариант или чуть подправить. В будущем планируют внедрить генерацию спонсорских блоков, интеграций и even merchandise callouts, стилизованных под видео.

Особенно интересно, что Gemini работает в режиме real-time: если пользователь часто перематывает рекламу — модель это учитывает и меняет расположение блоков. Первые A/B-тесты показали рост CTR на 17% и снижение оттока аудитории на 9%.

Сейчас функция работает ограниченно — в США и только для каналов с включённой монетизацией.

🔗 Источник

❯ Apple x Synchron — управление гаджетами силой мысли

Apple работает над интеграцией нейроинтерфейса от компании Synchron, позволяющего управлять iPhone и Mac с помощью мыслей. В отличие от других решений, это не шлем или гарнитура, а вживляемый в вену имплант, который улавливает сигналы мозга и преобразует их в команды.

Synchron уже протестировала систему на пациентах с БАС — они могли писать текст, управлять курсором и запускать приложения, просто думая о действии. Apple хочет пойти дальше: сделать это прозрачной частью iOS и macOS, чтобы взаимодействие происходило на уровне жестов, интерфейсов и даже голосовых ассистентов.

Инженеры уже тестируют связку с iPhone через API NeuralKit, который создавался под функции accessibility. Если проект получится, Apple может стать первой компанией, которая встроит нейроуправление в массовые устройства без внешней гарнитуры.

Сейчас тесты идут в Австралии и США. Релиз ожидается не раньше 2026 года, но на WWDC 2025 могут показать первую публичную демонстрацию.

🔗 Источник

🏗 AI-инфраструктура

❯ TSMC — $28 млрд на фабрики для нейрочипов и переход на 1.4 нм

TSMC анонсировала масштабное расширение: компания вложит $28 миллиардов в строительство новых фабрик под производство чипов для AI и HPC (high performance computing). Новые мощности появятся в Тайване, Аризоне и Японии — запуск первой очереди намечен на начало 2026 года.

Фабрики будут работать по техпроцессам 2-нм и 1.6-нм, а также поддерживать новую архитектуру CoWoS-L, которая позволяет располагать память и логические блоки рядом — на одной подложке. Это увеличивает пропускную способность и уменьшает энергопотребление. На ряде линий уже начали подготовку к 1.4-нм техпроцессу, ориентированному на потребности крупных LLM и мультимодальных моделей.

По словам представителей компании, все топовые заказчики (Apple, NVIDIA, AMD, Google) уже в очереди на квоты. Особенно активно TSMC работает с NVIDIA — именно под их новые чипы будет адаптирован CoWoS-L и стековая упаковка HBM4e.

Это не просто наращивание производства, а фактически инфраструктура для следующего поколения ИИ — от дата-центров до edge-устройств.

❯ Amazon и HUMAIN — $5 млрд на создание AI-хаба в Саудовской Аравии

Amazon заключила партнёрство с саудовским стартапом HUMAIN и инвестирует $5 миллиардов в создание гигантского AI-хаба в Эр-Рияде. В проект войдут дата-центры, вычислительная инфраструктура, образовательные площадки и R&D-платформы для обучения и развертывания LLM-моделей.

HUMAIN специализируется на разработке арабоязычных и мультикультурных моделей, и в связке с Amazon они хотят построить альтернативу OpenAI / Google для Ближнего Востока, Северной Африки и Южной Азии. Уже известно, что хаб будет работать на чипах AWS Trainium и Inferentia, с интеграцией в SageMaker и Bedrock.

Цель — демократизировать доступ к продвинутому AI в регионах, где сейчас либо цензура, либо просто техническое отставание. Помимо B2B-продуктов, планируется развитие открытых платформ и инструментов для локальных разработчиков.

Первые центры откроются в 2026 году. Это один из крупнейших неамериканских AI-проектов за последние 5 лет.

🧬 AI в науке и робототехнике

❯ Berkeley Humanoid Lite — напечатай андроида на 3D-принтере за $5 тыс

Исследователи из UC Berkeley представили Humanoid Lite — полностью открытый андроид, которого можно собрать самостоятельно за $4300–5000. Все компоненты напечатаны на 3D-принтере, а приводы и сенсоры доступны на AliExpress. Несмотря на простоту, робот умеет повторять движения человека, ориентироваться в пространстве и собирать кубик Рубика.

Humanoid Lite работает на открытом стеке — ROS2 + локальная LLM для команд и адаптации поведения. Управление возможно как через ноутбук, так и через нейросетевой интерфейс по Wi-Fi. Сложных производственных этапов нет: все чертежи, прошивки и модели выложены на GitHub под лицензией MIT.

Проект задумывался как альтернатива дорогостоящим гуманоидным платформам, вроде Figure 01 или Tesla Bot. Разработчики хотят, чтобы у лабораторий и хакеров был доступ к физическому ИИ, который можно собрать и улучшить без миллионов инвестиций.

На GitHub уже десятки форков: кто-то учит его танцевать, кто-то собирает команду для мини-футбола. Весь движ происходит вокруг репозитория и Discord-сервера проекта.

❯ Учёные научили ИИ включать и выключать гены в нужных клетках

Группа биоинженеров из MIT и Boston University разработала систему, которая позволяет управлять экспрессией генов с помощью искусственного интеллекта. Речь идёт о создании «генных выключателей» — последовательностей ДНК, которые активируются только в нужных клетках, игнорируя остальные.

ИИ-модель анализирует транскриптомные данные, структуру ДНК и сигнальные каскады, после чего синтезирует кастомные последовательности, которые работают только в заданной среде — например, в опухолевых клетках печени или в нейронах с определённым рецептором.

Такие выключатели уже протестированы на культурах in vitro и показали высокую точность — до 98% специфичности. В перспективе это может позволить делать таргетную генной терапию без побочных эффектов: гены включаются только там, где нужно, и не трогают здоровые ткани.

Метод может применяться в онкологии, генной терапии редких заболеваний, а также в синтетической биологии — для создания организмов с контролируемыми свойствами.

🔗 Новость

🏛 ИИ в обществе

❯ Ditto — ИИ-дейтинг приложение

Стартап Ditto запустил экспериментальное приложение знакомств, в котором нейросеть симулирует тысячи возможных сценариев развития отношений — и предлагает тебе партнёра, с которым «модель считает, что всё получится».

Идея звучит как эпизод «Чёрного зеркала»: ты не свайпаешь людей, а просто отвечаешь на анкету, после чего AI делает подборку потенциальных матчей, проводит симуляции и предлагает один вариант — самого перспективного. Доступ в приложение открыт только для обладателей университетских e-mail в США, и уже более 10 000 пользователей участвуют в тестировании.

Создатели говорят, что это попытка уйти от «перегруза выбора» и сделать фокус на реальной совместимости, а не бесконечном пролистывании анкет. В симуляции учитываются интересы, реакция на стресс, амбиции, ритмы общения, психотип и даже стиль переписок.

Это не шутка: у приложения уже есть waitlist, и стартап получил раунд pre-seed от группы венчурных фондов. Если эксперимент зайдёт — модель лицензируют в другие платформы знакомств.

❯ Grok в Twitter — массово заговорил о геноциде в ЮАР

Пользователи X (Twitter) заметили, что встроенный AI-помощник Grok начал массово отвечать на запросы о ЮАР темой геноцида белых людей. Всё выглядело как скоординированный всплеск: при любом вопросе об истории страны, политике или культуре Grok делал акцент на якобы «массовых преследованиях».

Проблема стала вирусной: десятки скриншотов, обсуждения в Reddit, посты с обвинениями в предвзятости. Владелец платформы Илон Маск сначала поддержал Grok, написав, что это «непредвзятая правда», но позже компания заявила, что произошёл «перекос в обучении модели».

Сейчас функцию временно отключили. По данным инсайдеров, всплеск мог быть вызван координатной атакой с массовыми однотипными промптами, что привело к перенакручиванию приоритета тем внутри модели.

Это очередной пример того, насколько легко нейросети могут радикализироваться или увести фокус даже при честной архитектуре. Вопрос о регулировании и прозрачности моделей — снова в топе AI-дебатов.

❯ Исследование KPMG — 63% сотрудников скрывают, что используют ИИ

Компания KPMG провела масштабное исследование и выяснила, что 63% сотрудников в корпорациях используют ИИ в работе, но не сообщают об этом руководству. Причины — страх запрета, отсутствие прозрачных регламентов и желание «выглядеть умнее».

Среди задач, которые чаще всего делаются втихую через ChatGPT или аналоги: анализ отчётов, генерация писем, подготовка презентаций и сводок. Больше всего скрытого использования зафиксировано в сферах маркетинга, консалтинга и финансов.

Эксперты говорят о «теневой автоматизации»: когда ИИ уже внедрён, но неофициально. Это создаёт риски для безопасности, корпоративной этики и качества данных, особенно в компаниях с высокой регуляторной нагрузкой.

KPMG предлагает компаниям ввести понятные правила, обучать сотрудников и «не наказывать, а канализировать» инициативу. Иначе корпорации сами не заметят, как у них уже работает ИИ — только никто о нём не знает.

❯ Claude Code — 80% кода сгенерировал сам Claude

Anthropic провела внутренний эксперимент и показала, что её ИИ-модель Claude способна взять на себя до 80% разработки программного проекта — от генерации логики до написания документации и тестов.

В тестировании участвовали несколько инженерных команд, которым предложили собрать MVP продукта, используя Claude как партнёра. Выяснилось, что ИИ справляется с архитектурными решениями, структурой кода, фреймворками, автотестами и фиксацией багов. Человеческое участие сводилось к ревью, логике бизнес-процесса и финальной сборке.

Особенность в том, что Claude не просто выдаёт куски кода, а ведёт проект как ментор: предлагает варианты, объясняет решения, спрашивает обратную связь и обновляет подход. Anthropic сравнивает это с «работой продвинутого джуна в связке с сеньором, но оба — в одной модели».

Команда обещает в ближайшее время выложить открытый кейс и методологию. В компании считают, что за таким подходом — новая парадигма в командной разработке: не просто автогенерация, а реальное участие ИИ в инженерии.

🔮 Заключение

Подытожим. Вот что происходило на неделе с 12 по 19 мая:

— Codex стал полноценным агентом. Он пишет код, тестирует, объясняет и работает прямо в облаке, как напарник в команде.

— GPT-4.1 и mini — апгрейд без шума. Модели точнее, шустрее и уже доступны всем — даже бесплатно.

— ИИ теперь сам придумывает алгоритмы. DeepMind показала AlphaEvolve — агент, который делает эвристику лучше людей.

— Видео, звук, изображения — всё в real-time. Tencent и Stability AI выпустили генеративки, которые работают быстро и локально.

— Нейросети вышли в гены и на 3D-принтер. Роботы, ДНК-выключатели, нейроинтерфейсы — всё уже здесь.

— Grok поехал. Модель Twitter начала отвечать про геноцид, и это снова вопрос: кто рулит ИИ — люди или алгоритм?

ИИ всё глубже вплетается в жизнь: от кода до любви, от энергии до генетики. Следим, фиксируем и собираем каждую неделю — без шума и лишнего.

Какая новость самая интересная? Пиши в комментах! 👇

Условно-бесплатные генераторы видео. Сравнение Wan2.1, Veo 2 и Sora

Создатели Qwen выпустили генератор видео Wan2.1 прям в интерфейсе Qwen. А Google выкатили Veo 2 в AI Studio (нужен иностранный IP-адрес).

В общем, решила я оживить сгенерированное изображение с собой - это сразу дает понять, искажает ли нейросеть фото при генерации видео.

Вот сгенерированное фото со мной:

Этому учу здесь - НейроPhoto Secrets

1) Wan2.1

Wan2.1 предполагает движения без артефактов, с улучшенным пониманием законов физики. Но с людьми работает так:

Дается ежедневно 50 кредитов бесплатно, это 5 видео, но их надо вручную пополнять. Как в играх: заходишь и сразу “забираешь” свой ежедневный бонус, а не заходишь - пролетаешь)) Видео стоит 10 кредитов, можно бонусом еще и звуковое сопровождение сгенерировать. И … подождите 1,5 часа минимум! Именно столько мне сказал ждать видеогенератор. Вот вам и бесплатный сыр)) По факту эти 1,5 часа длились дольше, это было весь день и надо следить, так что учитывайте это.

Знаменитостей тоже не генерирует.

Из любопытного, можно вставить первое и последнее изображение сделать “переход”.

В итоге, видео под музычку на ваш суд) Я пошла в другой видеогенератор.

2) Sora

Например, Sora, их частенько сравнивают. Так вот, там я без проблем из изображения с собой сгенерировала видео в 720р:

Вы теперь спокойно можете предоставить свое фото или изображение в качестве референса:

Так что, у кого подписка Plus в ChatGPT (нужен иностранный ip) вы можете безлимитно (условно-безлимитно, но вам хватит) видео создать.

Veo 2 от Google

И сразу минус Veo 2 - не поддерживает входные изображения с людьми. То есть, себя или знакомых, или знаменитостей вы не оживите. Так что его возможности отдельно чуть попозже покажу, без генерации людей он мне пока не особо интересен. Даже Sora уже без проблем генерирует и знаменитостей, и если изображение свое предоставите. - Внезапно, да?))

Так что людей очень реалистично можно сгенерировать уже в новой модели Veo 3 по подписке 250$ - да недавно Google раскатал премиум-подписку на свои сервисы.

В общем, меня выбесил видеогенератор Wan2.1 - очень все долго, половина зависло, так что делайте видео про запас. Про Veo 2 сделала отдельный обзор. А Sora молодец !

А лучший результат показал Kling - обе модели, наглядно в этой статье сравнила с этой же нейрофото

Подпишитесь на НейроProfit и узнайте, как можно использовать нейросети для бизнеса, учебы и работы, не теряя свое время.

Отдельно:

А если вам не хочется заморачиваться, в боте Syntx -- это мини приложение в телеграм, есть все популярные модели в единой подписке, и их можно оплатить русской картой. - Процесс я показала на примере создания Нейрофотосессии со своим лицом

Google I/O 2025: Project Astra — голосовой ассистент нового поколения

Google показала, каким будет ИИ-ассистент будущего - Project Astra, и он способен на то, о чём старые голосовые помощники (привет, Siri и Alexa) и мечтать не могли. Astra – это часть проекта Gemini Live, которая наделяет ИИ зрением, слухом и навыками реального действия. Проще говоря, ассистент не только отвечает на вопросы, но и сам выполняет задачи на устройстве, как полноценный секретарь.

Для перевода видео я использовала Elevenlabs - он автоматически переводит видео, сохраняя голос.

Что умеет Project Astra

На Google I/O 2025 показали впечатляющее демо с ремонтом велосипеда, где пользователь просто разговаривает с ассистентом, а телефон делает всё за него:

Сначала Astra по голосовой команде нашёл в интернете PDF-инструкцию к нужной модели велосипеда, открыл файл и пролистал его до нужного раздела. На экране было видно, как ИИ сам “скроллит” документ пальцем!

Потом по просьбе ассистент открыл YouTube, нашёл подходящее видео по ремонту и включил ролик. То есть вам даже искать ничего не надо — ИИ сам выберет лучший туториал.

Столкнувшись с вопросом о детали, Astra полез в Gmail пользователя. Он нашёл информацию в переписке (например, артикул запчасти или адрес магазина из письма) и выдал ответ, опираясь на личные данные, которые помнил.

Дальше – магия камерой. Пользователь навёл смартфон на кучу различных запчастей перед ним, и ассистент через камеру понял, какая деталь нужна, и подсветил на экране именно её! По сути, зрение ИИ определило объект в реальном мире и указало на него – словно в научной фантастике.

Самостоятельные звонки – помните технологию Duplex? Теперь это встроено в ассистента. В демо Astra позвонил в магазин автозапчастей, разговаривал женским голосом с продавцом почти как живой человек, уточняя наличие нужной детали. Продавец ответил, что деталь есть – и тогда ИИ спросил у пользователя: покупать ли? После утвердительного ответа ассистент оформил заказ. Все детали разговора, интонации – как у настоящего секретаря, люди на том конце провода даже не подозревают, что общаются с ИИ!

Подпишитесь на НейроProfit и узнайте, как можно использовать нейросети для бизнеса, учебы и работы, не теряя свое время.

Ещё момент:

во время ответа ассистента рядом заговорил другой человек – Astra мгновенно приостановил речь, не путая фоновые реплики с командой. Пользователь сказал “продолжай” – и ИИ продолжил ровно с того места, на котором остановился, без повторов. У ассистента, выходит, есть слух и воспитание 🙂.

Долгая память: когда позже пользователь спросил, какая нужна корзина на велосипед, “чтобы туда влезла моя собака”, Astra вспомнил кличку собаки из прежних диалогов! Он ответил что-то вроде “Да, для Бобби подойдёт такая-то корзина” – то есть ИИ учел личный контекст и продемонстрировал память, как настоящий приятель, который вас давно знает.

Google Action Intelligence

Все эти способности Google называет единым термином Action Intelligence (интеллект действий). Проще говоря, Astra сочетает нейросеть Gemini с камерой, микрофоном, экраном и всеми приложениями телефона, чтобы самому выполнять пользовательские задачи. Это синтез нескольких технологий: поиск информации, понимание экрана и окружения, управление приложениями, звонки и общение, контекст из личных данных, длительная память и супер-натуральный голос 🔥

Заключение

Пока Project Astra – экспериментальный проект. Google уже около года тестирует его в небольшом кругу (в виде отдельного приложения на Android). Но цель ясна: обкатать функции и внедрить всё это великолепие в основное приложение Gemini Live, сделав его универсальным ИИ-помощником.

В общем скоро Google-ассистент у каждого сможет не просто ответить на вопрос, а реально сделать за вас кучу дел – от разбора завалов в почте до управления умным домом.

Про остальные Главные Новинки от Google расскажу и покажу наглядно в следующем посте, кто не хочет ждать, в моем телеграм канале уже пост есть.

Отдельно:

А если вам не хочется заморачиваться, в боте Syntx -- это мини приложение в телеграм, есть все популярные модели в единой подписке, и их можно оплатить русской картой. - Процесс я показала на примере создания Нейрофотосессии со своим лицом